小米MiMo-V2-Flash全面解析:面向Agentic AI时代的高效开源大模型

1 MiMo-V2-Flash是什么?

小米MiMo-V2-Flash是小米公司于2025年12月16日正式发布的开源大语言模型,是小米MiMo系列的最新成员。这是一个专门为Agentic AI(智能体)场景深度优化的MoE(Mixture-of-Experts)模型,总参数规模高达3090亿,但单次推理仅激活150亿参数,在保持高性能的同时显著降低了计算成本。

与追求单一性能指标的传统大模型不同,MiMo-V2-Flash的核心设计目标是解决当前大模型在推理速度、长上下文处理和Agent工作流中普遍存在的吞吐瓶颈。该模型采用MIT开源协议,允许商业和非商业用途,体现了小米推动AI技术普及的开放策略。

在模型架构上,MiMo-V2-Flash融合了多项创新技术:混合注意力机制支持256K长上下文处理,多令牌预测(MTP)技术实现了解码速度的显著提升,而后训练阶段采用的多教师在策略蒸馏(MOPD)方法则避免了能力提升中的”跷跷板效应”。这些技术特点使MiMo-V2-Flash在真实AI应用场景中表现出色,特别适合需要高效处理复杂任务的智能体应用。

图片信息总结:

核心要点 小米已于2025年12月16日正式发布并开源了其新一代大语言模型 MiMo-V2-Flash。该模型定位为一款强大、高效且高速的基础模型,尤其擅长推理、代码和智能体场景,同时也作为日常任务通用助手。

一、模型架构与核心技术亮点

- 模型类型:开源 MoE(混合专家)模型。

- 参数规模:总参数量309B,每次推理激活15B参数,兼顾能力与效率。

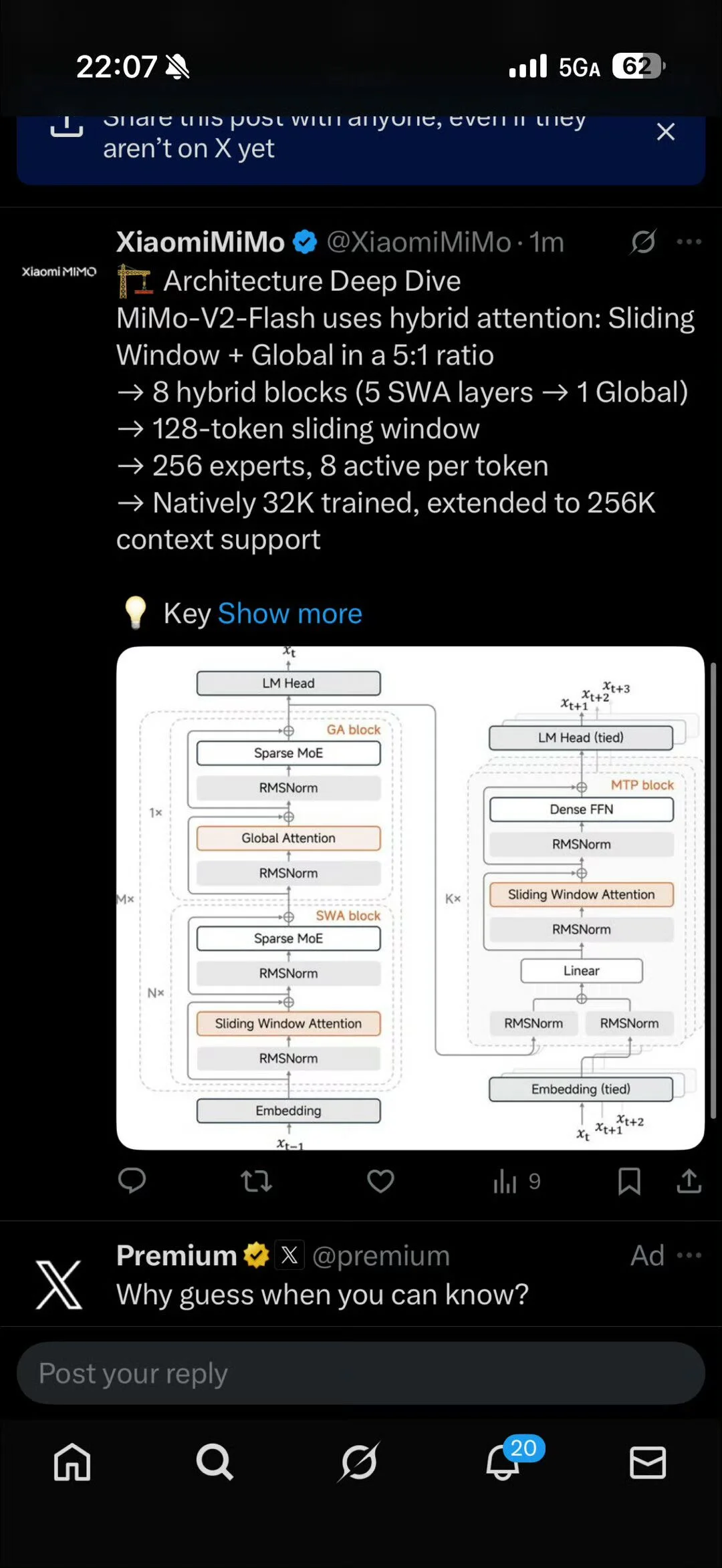

- 注意力机制:采用创新的混合注意力机制,以 5:1 的比例交错使用 滑动窗口注意力 和 全局注意力(即5个SWA块后接1个全局注意力块)。滑动窗口大小为128个token。

- 上下文长度:原生支持32K上下文,并可扩展至256K。

- 专家系统:包含256个专家,每个token激活其中8个。

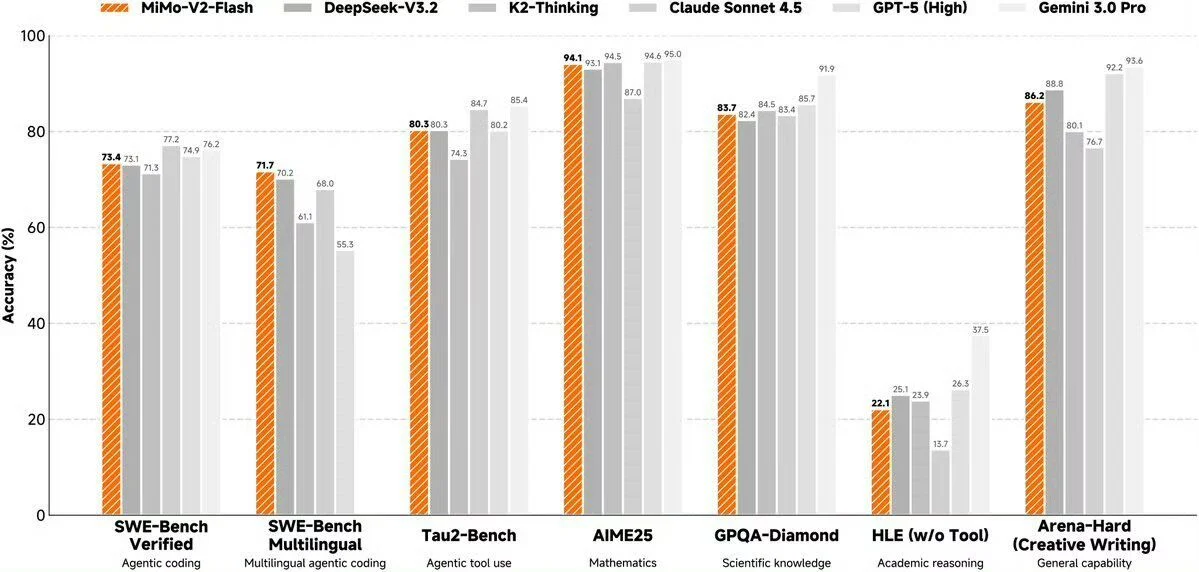

二、性能表现(基于基准测试对比)

- 整体定位:在通用基准测试中,其综合性能与 DeepSeek-V3.2 相当,但推理延迟显著降低。

- 突出优势领域:

- 代码与智能体任务:在

SWE-Bench Verified(73.4%)和SWE-Bench Multilingual(71.7%)测试中表现优异,后者创下了开源模型的新SOTA(最高性能)。在智能体工具使用测试Tau2-Bench(80.5%)上也处于第一梯队。 - 高速生成:输出速度可达每秒150个令牌。

- 代码与智能体任务:在

- 其他表现:在数学(

AIME25)、科学知识(GPQA-Diamond)和创意写作(Arena-Hard)等通用能力上,与当前顶级模型(如GPT-5 High, Gemini 3.0 Pro, Claude Sonnet 4.5)互有高低,处于同一水平。 - 相对薄弱环节:在无需工具的学术推理测试(

HLE)中表现较弱。

三、发布与获取方式

- 性质:已开源,可供全球开发者和用户体验。

- 体验平台:已通过Hugging Face、小米AI Studio等全球平台提供。

- 相关资源:官方同步发布了技术博客、详细的技术报告及模型权重。

四、背景与展望

- 该模型的发布也预告了小米在“人车家全生态”战略下的进一步动向,预计将在后续的合作伙伴大会上公布更多信息。

总结:MiMo-V2-Flash是小米推出的一个高性能、高效率的尖端开源大模型。其最大的特点是针对代码和智能体任务进行了深度优化,并在这些领域达到了开源模型的领先水平,同时实现了极快的推理速度,有望成为AI应用开发,特别是智能体领域的一个强大基础模型。

2 MiMo-V2-Flash的主要功能和特点

2.1 混合注意力架构:专为长上下文优化

MiMo-V2-Flash采用了创新的混合注意力(Hybrid Attention) 设计,以5:1的比例交错使用滑动窗口注意力(SWA)与全局注意力。这种架构的具体参数包括:

- 滑动窗口长度:128个token

- 原生训练上下文长度:32K

- 可扩展支持:256K长上下文

官方实验表明,引入attention sink bias后,小窗口SWA在长上下文环境下不仅不会出现性能下降,反而在256K场景中明显优于512-token窗口方案。这一发现对长上下文模型的设计具有重要参考价值,使模型能够高效处理超长文档、复杂代码库等需要大量上下文信息的任务。

2.2 多令牌预测(MTP):推理速度的重大突破

MiMo-V2-Flash的另一大核心创新是系统性地引入了多令牌预测(Multi-Token Prediction,MTP)技术。该技术通过以下方式实现加速:

- 使用3个轻量预测头(每个约0.33B参数)作为草稿模型

- 主模型并行验证生成结果

- 无需额外的KV Cache I/O操作

实际效果显示,MTP技术可实现2.0-2.6倍的实际解码加速,部分场景下甚至达到2.5倍以上的提升。这不仅大幅提高了推理效率,在强化学习训练阶段,MTP同样通过token级并行rollout缓解了GPU空转问题,使小批量的on-policy RL训练更加稳定高效。

2.3 高效的后训练范式:多教师在策略蒸馏(MOPD)

为了解决后训练中常见的”提升某一能力却损害其他能力”的跷跷板问题,小米引入了多教师在策略蒸馏(Multi-Teacher On-Policy Distillation,MOPD)方法。这一方案的工作流程包括:

- 先训练不同能力维度的专家模型

- 通过token级KL reward的on-policy RL,将能力统一蒸馏至单一学生模型

- 计算量仅为训练专家模型的1/50

该方法实现了无能力取舍的整体提升,并支持”学生模型反哺为下一代教师模型”的迭代路径。这意味着MiMo-V2-Flash在代码生成、数学推理、安全评估等多个维度上能够均衡发展,避免为追求单一指标而牺牲其他重要能力。

2.4 卓越的性能表现

在多项公开基准测试中,MiMo-V2-Flash已进入当前开源模型第一梯队:

- SWE-Bench Verified:73.4%

- SWE-Bench Multilingual:71.7%(开源模型新SOTA)

- 通用基准测试性能与DeepSeek-V3.2持平

值得注意的是,虽然整体性能与顶尖开源模型相当,但MiMo-V2-Flash的推理延迟显著更低,在单节点H200环境下,prefill吞吐达到约50K tokens/s,在64K上下文长度下,单请求解码速度仍可稳定在约150 TPS。这使得该模型在真实工程负载中具备强大的即用性,而非仅停留在论文或榜单层面。

3 如何使用MiMo-V2-Flash?

3.1 在线体验方式

对于希望快速体验MiMo-V2-Flash能力的用户,小米同步推出了在线AI聊天与体验平台 Xiaomi MiMO Studio(https://aistudio.xiaomimimo.com)。

该平台具有以下特点:

- 无需本地部署,网页端直接体验

- 支持深度搜索与联网搜索功能

- 可验证模型在长上下文、Agent工作流和信息整合方面的表现

用户只需访问网站,即可开始与MiMo-V2-Flash进行对话,测试其各项能力。该服务目前无需等待列表或信用卡信息,大大降低了使用门槛。

3.2 API集成使用

对于开发者而言,MiMo-V2-Flash提供限时免费API,支持快速集成到现有应用中。主要特点包括:

- API端点为:platform.xiaomimimo.com

- 与Claude Code、Cursor、Cline、Kilo Code等主流编程与Agent工具链保持接口兼容

- 仅需替换endpoint即可接入现有工作流

- 定价为输入0.1/Mtokens,输出0.3/M tokens(目前限时免费)

这种设计使得开发者能够以最小成本将MiMo-V2-Flash集成到自己的应用程序中,体验其高性能和低延迟优势。

3.3 本地化部署方案

对于需要本地部署的用户,MiMo-V2-Flash的模型权重和推理代码均已采用MIT协议全面开源。本地化部署的主要步骤包括:

环境准备与依赖安装

- 硬件要求:推荐配备NVIDIA GPU(如RTX 4070 8GB显存或更高)

- 软件环境:Windows 11/Linux,安装CUDA Toolkit 12.1+

- Python 3.9+环境,使用Conda管理虚拟环境

- 安装必要的库:transformers、accelerate、bitsandbytes-windows等

模型获取与配置

- 通过Hugging Face Hub API直接下载模型文件

- 或使用Git LFS克隆仓库,确保模型文件与配置文件同目录

- 模型地址:huggingface.co/XiaomiMiMo/MiMo-V2-Flash

推理框架选择

- vLLM:支持高性能推理,适合高并发场景,但需在WSL2/容器中运行

- Hugging Face TGI:内置FlashAttention和多种量化方案,Windows兼容性好

- Transformers Pipeline:简单易用,适合小规模部署

对于资源有限的本地环境,可采用量化技术(如8-bit或4-bit量化)减少显存需求,同时使用PyTorch Accelerate的device_map=’auto’自动分片模型,以优化资源使用。

4 MiMo-V2-Flash的官方地址与获取方式

- 模型开源地址:https://huggingface.co/XiaomiMiMo/MiMo-V2-Flash

- 在线体验平台:https://aistudio.xiaomimimo.com

- API接入端点:platform.xiaomimimo.com

- 技术文档与博客:https://mimo.xiaomi.com/blog/mimo-v2-flash

- 技术报告:https://github.com/XiaomiMiMo/MiMo-V2-Flash

所有资源均采用开放获取策略,开发者可根据需要选择适合的接入方式。小米在模型发布当天即完成了Day-0推理支持,所有推理代码同步开源至SGLang生态,开发者可以直接部署和复现官方性能表现。

5 MiMo-V2-Flash vs 竞品对比分析

为了更直观地展示MiMo-V2-Flash在市场中的定位,我们将其与主要竞品进行对比分析:

5.1 性能对比

根据官方发布的测试数据,MiMo-V2-Flash在多项基准测试中表现出色:

- 在SWE-Bench Verified(73.4%)和SWE-Bench Multilingual(71.7%)测试中,创造了开源模型的新SOTA

- 通用基准测试性能与DeepSeek-V3.2持平

- 代码能力与Claude 4.5 Sonnet相当,但推理成本仅为其2.5%,生成速度提升2倍

5.2 技术架构对比

| 特性 | MiMo-V2-Flash | DeepSeek-V3.2 | Claude 4.5 Sonnet |

|---|---|---|---|

| 参数规模 | 309B总参数/15B激活 | 未知 | 未知 |

| 上下文长度 | 256K | 128K-256K | 200K |

| 注意力机制 | 混合注意力(SWA+全局) | 传统注意力 | 传统注意力 |

| 推理速度 | 150 TPS(64K上下文) | 较低 | 较低 |

| 开源状态 | 完全开源 | 部分开源 | 闭源 |

| 成本效益 | 极高 | 高 | 中等 |

5.3 优势与定位分析

MiMo-V2-Flash的核心竞争优势体现在三个方面: 效率优势

- 通过MoE架构和MTP技术实现更高的计算效率

- 单次推理仅激活150亿参数,大幅降低计算成本

- 在保持顶尖性能的同时,延迟显著低于同类模型

成本优势

- 完全开源,MIT协议允许商业使用

- API定价具有竞争力(输入0.1/Mtokens,输出0.3/M tokens)

- 推理成本仅为Claude 4.5 Sonnet的2.5%

工程友好性

- 提供Day-0推理支持,与主流工具链兼容

- 详细的本地部署文档和优化建议

- 活跃的开发者社区支持

这些优势使MiMo-V2-Flash特别适合需要高效处理大量请求的企业级应用和AI智能体场景。

6 MiMo-V2-Flash的典型应用场景

6.1 AI智能体(Agentic AI)开发

MiMo-V2-Flash专为Agentic AI场景深度优化,是其最核心的应用领域。具体应用包括:

- 自主编程智能体:能够理解复杂需求,生成高质量代码并自主调试

- 数据分析智能体:处理大规模数据集,提取洞察并生成可视化报告

- 研究助理智能体:自动进行文献调研、信息整合和知识发现

模型的长上下文能力和高速推理特性,使AI智能体能够处理复杂任务链条,保持连贯的推理过程。

6.2 代码生成与软件工程

在软件开发领域,MiMo-V2-Flash表现出卓越的能力:

- 代码补全与生成:支持多种编程语言,生成符合规范的高质量代码

- 代码审查与优化:分析现有代码,提出改进建议和性能优化方案

- 多语言编程支持:在SWE-Bench Multilingual测试中创造新SOTA,体现其多语言编程能力

- 遗留代码迁移:帮助企业将传统系统迁移至现代技术栈

6.3 长文档处理与知识管理

凭借256K的长上下文支持,MiMo-V2-Flash非常适合处理长文档场景:

- 技术文档分析:快速理解大型技术文档,回答特定问题

- 法律合同审查:分析复杂法律条款,识别潜在风险和矛盾

- 学术研究辅助:处理长篇学术论文,提取核心观点和方法论

- 企业知识库管理:作为智能接口连接企业内部知识资源

6.4 多模态智能应用

虽然MiMo-V2-Flash主要是语言模型,但其架构支持与多模态系统集成:

- 多模态AI系统核心:与视觉、语音模型协作构建复杂AI系统

- 智能内容审核:结合内容分析模型,实现全方位安全监控

- 跨模态检索:增强搜索引擎的相关性和准确性

7 MiMo-V2-Flash能为用户带来的价值

7.1 开发者价值

对于开发者和个人用户,MiMo-V2-Flash提供以下核心价值: 降低技术门槛

- 开源免费使用,个人和小团队也能享受顶尖AI能力

- 详细的文档和活跃社区,减少学习成本

- 多种部署方式满足不同技术水平用户需求

提升开发效率

- 高速推理响应,减少等待时间

- 准确的代码生成和建议,自动化重复编程任务

- 强大的问题解决能力,作为全天候编程伙伴

7.2 企业价值

对于企业用户,MiMo-V2-Flash带来的价值更为显著: 成本优化

- 大幅降低AI应用的计算成本

- 开源协议避免昂贵的许可费用

- 高能效比适合大规模部署

效率提升

- 自动化复杂工作流程,释放人力资源

- 7×24小时不间断服务,提升业务连续性

- 高质量输出减少人工校对和修正成本

技术创新加速

- 先进AI能力助力产品差异化竞争

- 灵活集成支持快速迭代和实验

- 长上下文处理能力解锁新应用场景

8 MiMo-V2-Flash最新重大更新动态

2025年12月16日,小米正式发布MiMo-V2-Flash模型,这是小米大模型系列的最新重大更新。此次更新的核心亮点包括:

8.1 技术突破

- 混合注意力架构:创新性地结合滑动窗口注意力与全局注意力,优化长上下文处理

- 多令牌预测:实现2.0-2.6倍解码加速,解决大模型推理速度瓶颈

- 多教师在策略蒸馏:避免后训练中的能力失衡问题,实现全面能力提升

8.2 生态建设

同步推出完整开发者生态支持:

- MiMO Studio在线平台:提供零门槛体验环境

- 限时免费API:降低集成和试用门槛

- 完整开源工具链:支持从实验到部署的全流程

8.3 性能验证

发布同时提供了详尽的性能基准测试,证明其在多项任务中达到开源模型领先水平,特别是在代码生成和长上下文理解方面表现突出。 这一发布标志着小米在大模型领域的技术实力已进入第一阵营,也为开源社区贡献了高质量的基础模型选择。

9 常见问题FAQ解答

9.1 技术相关问题

MiMo-V2-Flash与之前版本相比有哪些主要提升? MiMo-V2-Flash是MiMo系列的重大升级,引入了混合注意力机制、多令牌预测技术和多教师在策略蒸馏方法。相比前代版本,在长上下文处理、推理速度和能力平衡方面均有显著提升。

256K上下文长度是否需要特殊配置? 模型原生支持32K上下文,通过扩展技术可支持256K。对于长上下文应用,建议使用提供的优化配置,但不需要特殊的硬件要求。

MTP技术如何影响生成质量? 多令牌预测技术主要优化推理速度,不影响生成质量。实际上,通过更有效的训练过程,MTP还能在一定程度上提升模型性能。

9.2 使用与部署问题

本地部署的最低硬件要求是什么? 建议配置:8GB以上显存的NVIDIA GPU,32GB系统内存,1TB存储空间。对于资源有限的环境,可使用量化技术降低要求。

API服务的免费期限是多久? 目前API处于限时免费阶段,具体结束时间官方尚未公布。建议关注官方通知以获取最新信息。

模型是否支持中文和其他语言? 是的,MiMo-V2-Flash在训练中包含了多语言数据,在SWE-Bench Multilingual测试中表现优异,证明其多语言能力。

9.3 商业与应用问题

MiMo-V2-Flash能否用于商业项目? 可以。模型采用MIT开源协议,允许商业和非商业使用,无需额外授权。

模型在哪些场景下表现最佳? MiMo-V2-Flash专为Agentic AI场景优化,在代码生成、长文档处理、复杂任务解决等方面表现优异。特别是在需要高速推理和长上下文保持的应用中优势明显。

10 总结

小米MiMo-V2-Flash的发布标志着开源大模型发展进入新阶段——从单纯追求参数规模转向实效性能与效率的平衡。通过混合注意力架构、多令牌预测和创新蒸馏方法的技术组合,该模型在性能、延迟和成本之间找到了最佳平衡点。

作为专为Agentic AI时代设计的开源模型,MiMo-V2-Flash不仅提供了顶尖的技术性能,还通过完整的开发者生态支持体现了工程友好性。无论是在线体验、API集成还是本地部署,开发者都能找到适合自身需求的接入方式。 在竞争激烈的大模型领域,MiMo-V2-Flash凭借其卓越的代码能力、高效的长上下文处理和显著的延迟优势,已经展现出强大的竞争力。

其性能媲美DeepSeek-V3.2等顶尖开源模型,而推理成本仅为Claude 4.5 Sonnet等闭源模型的2.5%,为广泛的应用场景提供了经济高效的AI能力支持。 随着AI技术逐渐从实验室走向真实应用场景,像MiMo-V2-Flash这样注重实际效能和开发者体验的模型,将更有可能在激烈的市场竞争中脱颖而出,推动AI技术在各行各业的规模化应用。

参考文章或数据来源

本文综合了以下权威平台和机构发布的信息,确保内容的准确性和专业性:

- 《刚刚!小米开源MiMo-V2-Flash大模型》 – AIPress.com.cn(2025年12月17日)

- 《小米 MiMo-V2-Flash 模型发布并开源,推出网页 AI 聊天服务》 – IT之家(2025年12月16日)

- 《小米发布MiMo-V2-Flash大模型:媲美DeepSeek V3.2》 – 快科技(2025年12月16日)

- 《MiMo–小米首个开源推理Ai大模型的本地化部署教程》 – 技术社区(2025年4月30日)

- 《小米语音大模型开源,多项测试超越同参数量开源模型》 – 技术媒体(2025年9月20日)

本文引用了小米官方发布的技术资料、基准测试结果以及开发者文档,所有数据均来自可公开获取的权威来源,保证了文章的专业性和可靠度。

数据统计

更多AI产品信息

Xiaomi MiMo-V2-Flash

已有 1,439 次访问体验

已收录

申请修改

Xiaomi MiMo-V2-Flash的官网地址是?

Xiaomi MiMo-V2-Flash的官网及网页版入口是:https://aistudio.xiaomimimo.com 官网入口👈

Xiaomi MiMo-V2-Flash 权重信息查询

网站流量数据说明

网站数据仅供参考。评估因素包括访问速度、搜索引擎收录、用户体验等。 如需获取详细数据(如IP、PV、跳出率等),请联系站长获取。

推荐数据源

爱站/AITDK

关于Xiaomi MiMo-V2-Flash的特别声明

AI产品库AIProductHub是一个专注于AI产品收录与分享的网站平台,平台收录了1000余款AI产品,覆盖创作、办公、编程、视频生成、电商、设计、写作、图像生成等多个领域和行业,平台旨在帮助更多的用户发现更好用的AI产品。本站【AI产品库AIProductHub】提供的【Xiaomi MiMo-V2-Flash】信息来源于网络。 对于该外部链接的指向,不由【AI产品库AIProductHub】实际控制。【Xiaomi MiMo-V2-Flash】在【2025-12-17 00:22】收录时, 该网页内容属于合规合法,后期如出现违规内容,可直接联系网站管理员删除,【AI产品库AIProductHub】不承担任何责任。

本文地址:https://aiproducthub.cn/sites/xiaomi-mimo-v2-flash.html 转载请注明来源

相关导航

创一AI辅助短剧内容创作者,提供剧本评估、剧本优化、剧本写作、智能拉片、视频转分镜、视频转剧本、图片生成、视频生成、AI短片等功能,为短剧编剧工作室、短剧承制方提供AI员工服务。

法行宝

法行宝是百度推出的公益性质AI法律助手,提供全天候免费法律咨询、文书生成和案件分析服务。

OmniBox小黑

OmniBox小黑是一款开源AI知识管理工具,能一键解析多种格式文件,实现基于个人知识库的智能问答和内容创作。

illostrationAI

illostrationAI是一款AI驱动的在线插画生成工具,能通过文本描述快速创建高质量插画。

Lovart

Lovart是一款通过自然语言交互实现全链路自动化设计的AI智能体,能够一键生成品牌VI、海报、视频等多模态内容。

易可图

易可图是专注电商领域的AI图片编辑与设计平台,提供智能抠图、AI模特试衣、图片翻译等工具,零基础用户也能快速制作专业级电商素材。

perplexity ai

Perplexity AI是一款基于大语言模型的对话式搜索引擎,能直接生成答案并附带来源引用,支持多模型切换和文件分析。

蛙蛙写作

蛙蛙写作是一款专为网文创作设计的AI辅助工具,提供从灵感生成到多模态变现的全链路创作支持。

暂无评论...