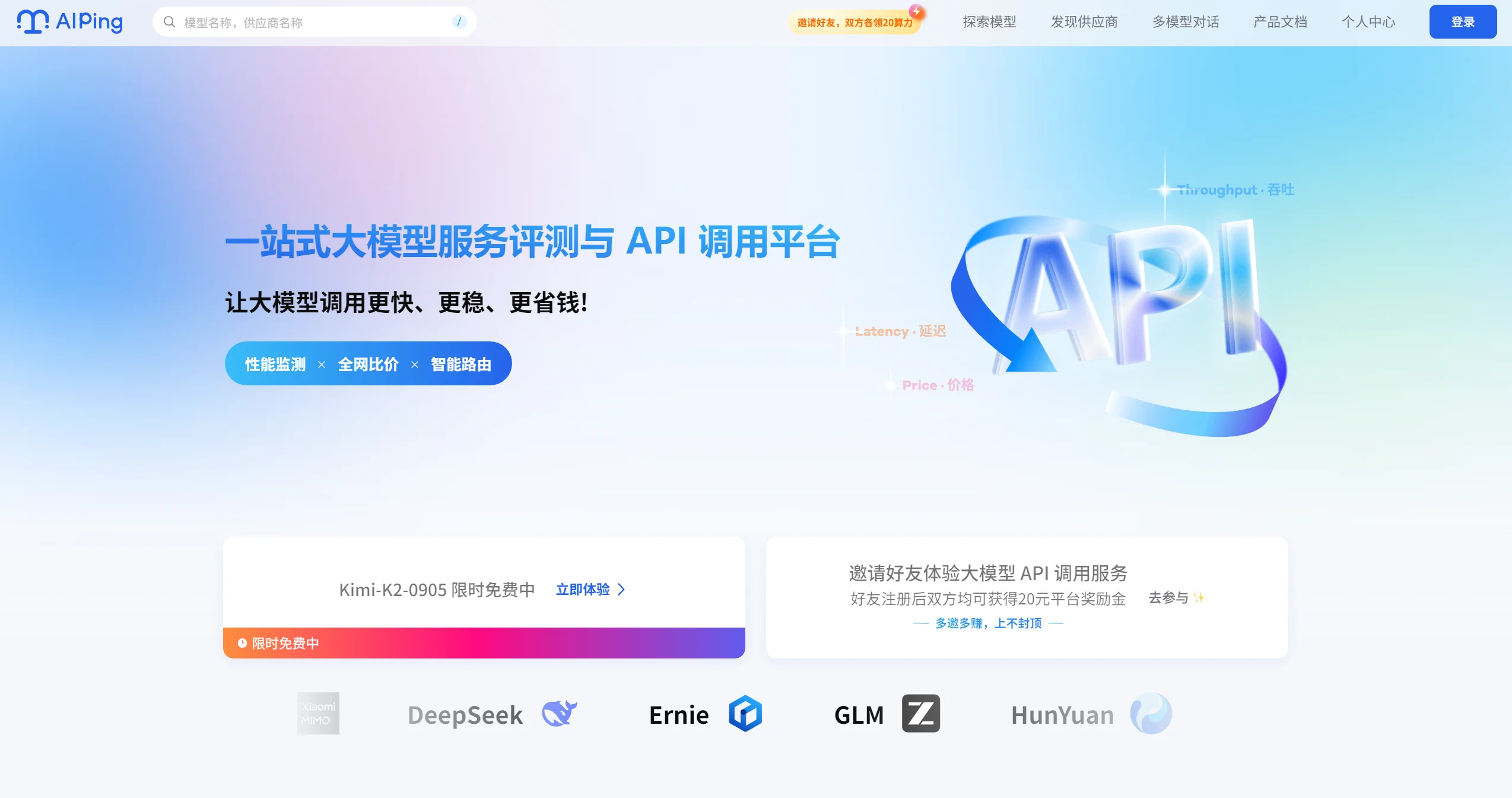

AI Ping是什么?开发者必备的大模型选型利器,提供20+供应商横向对比

AI Ping核心功能快览

AI Ping是清华系创业团队清程极智推出的大模型服务性能评测与信息聚合平台,被誉为”AI界的大众点评”。平台已整合20余家供应商的数百个模型服务,提供性能评测、统一API调用、智能路由和成本管理等功能。

通过7×24小时持续监测各模型服务的延迟、吞吐量、可靠性等关键指标,AI Ping为开发者提供客观、实时的选型参考,显著降低大模型使用门槛和成本。

1 AI Ping是什么?

AI Ping是一个面向大模型使用者的一站式服务评测与API调用平台,由清华系AI Infra创新企业清程极智推出。在2025年的技术版图中,随着大模型从实验室走向千行百业,开发者面临着模型选型困难、性能参差不齐、成本控制复杂等挑战。 AI Ping的核心定位是成为大模型服务的 “性能罗盘” ,通过标准化评测体系、全维度数据透视和场景化推荐引擎,为开发者拨开迷雾,找到最适合业务需求的大模型服务。

平台目前已整合20余家供应商的数百个模型服务,覆盖了行业主流的大模型生态。 与传统单一模型服务平台不同,AI Ping的创新之处在于构建了 “评测-分析-推荐”的完整闭环。

平台不仅提供性能数据,更通过智能路由技术实现自动选择最优模型,解决了企业因选型失误导致项目延期或超支的痛点。根据实际测试,通过AI Ping的智能路由平均可将延迟降低20%,吞吐提升33%,成本降低50%。

AI Ping关键信息列表:

- 推出时间:2024年(根据平台发展历程推断)

- 开发团队:清华系创业团队清程极智

- 模型覆盖:20+供应商、230+模型服务

- 核心功能:性能评测、统一API、智能路由、成本管理

- 典型用户:AI应用开发者、技术决策者、企业技术团队

2 AI Ping的主要功能和特点

2.1 全维度性能评测体系

AI Ping构建了全面的性能评测框架,通过7×24小时持续监测,提供客观、实时的大模型服务性能数据。评测体系涵盖以下核心指标:

- 延迟指标:重点关注P90首字延迟(First Token Latency at P90),衡量响应速度稳定性,反映用户实际体验中的”卡顿感”

- 吞吐量:以每秒处理token数(Throughput in tokens/s)反映服务吞吐能力,适用于高并发或长文本场景

- 可靠性评分:基于故障率、重试成功率等数据,量化模型服务的稳定性

- 成本分析:实时跟踪各模型的输入/输出价格,提供TCO(总拥有成本)计算

- 上下文长度:明确标注模型能处理的最大输入/输出长度,保障业务适配性

平台通过自动化脚本,定时对接各大主流MaaS平台API,采集真实调用数据,确保评测结果的客观性和可复现性。所有性能数据均为真实跑分+线上调用统计,非理论值或厂商宣传数据。

2.2 智能路由引擎

AI Ping的智能路由引擎是其核心技术优势,能够根据特定策略(如最低成本、最低延迟等)智能选择最合适的API供应商。该引擎的工作原理如下:

- 实时性能监控:每5分钟自动刷新各供应商状态,高峰时段增加监测频率至1分钟

- 多维度决策:基于延迟、吞吐、成本、可靠性等多维指标进行路由决策

- 异常处理:当某供应商延迟激增或吞吐骤降时,系统自动降权或切换备用节点

- 场景适配:支持根据不同任务类型(代码生成、文本创作、数据分析)选择最优模型

智能路由确保了每次请求都发往当前综合表现最优的服务商,真正实现”让大模型调用更快、更稳、更省”的承诺。

2.3 统一API门户

AI Ping提供标准化API接口,对接20+模型供应商,屏蔽底层差异。开发者只需使用一套API规范,即可调用不同供应商的服务,极大简化了开发流程。平台支持三种常见的API调用方式:

- OpenAI Python SDK:适合Python后端开发者,封装完善,代码简洁

- 基于requests的HTTP调用:适合通用开发者,灵活可控,易调试

- 使用curl的命令行调用:适合测试与运维人员,无依赖,快速验证

统一API设计使开发者可以在不修改整体工程结构的前提下,自由切换不同模型,非常适合用于模型对比测试、智能体系统集成以及实际业务场景落地。

2.4 成本管理与优化工具

AI Ping提供了强大的费用管理与分析工具,帮助团队实时监控API调用的费用。平台通过以下方式帮助用户优化成本:

- 价格对比功能:实时对比各供应商的价格策略,避免隐性成本

- 成本模拟器:输入业务量预测,自动计算TCO(总拥有成本)

- 免费资源整合:聚合多家平台的免费模型资源,如MiniMax-M2、GLM-4.6等

- 用量预警:可设置预算上限和用量阈值,及时发现异常开销

据统计,API调用成本占AI应用总成本的45%以上(Gartner数据),而AI Ping的成本管理功能可帮助企业有效控制预算。

2.5 开发者工具集成

AI Ping支持多种主流开发工具,实现”免跳转”开发体验。目前已集成的工具包括:

- VSCode插件Cline:提供实时API调用性能显示、成本预估与消耗监控

- Cursor IDE集成:深度集成AI Ping路由功能,支持免费模型自动选择

- Coze低代码平台:可快速搭建集成AI能力的应用

- Claude Code调试工具:提供代码生成和调试能力

这些工具集成使开发者能够在熟悉的环境中使用大模型能力,无需离开编辑器窗口,大幅提升开发效率。

3 如何使用AI Ping?

3.1 注册与初始设置

使用AI Ping的第一步是完成平台注册和基本配置:

- 访问官网:通过官方直达链接(https://aiping.cn)注册平台账号

- 获取API密钥:注册成功后,在个人中心创建API Key

- 配置开发环境:根据使用的编程语言和工具,安装相应的SDK或插件

新用户注册通常可获得一定额的算力金(如30元),用于初步体验平台服务。

3.2 基础API调用示例

AI Ping提供了与OpenAI风格一致的API调用方式,开发者可以直接使用熟悉的Python SDK快速完成模型调用。以下是一个基本的Python调用示例:

from openai import OpenAI

# 配置AI Ping客户端

openai_client = OpenAI(

base_url="https://www.aiping.cn/api/v1",

api_key="您的API_KEY", # 替换为实际API密钥

)

# 发起请求

response = openai_client.chat.completions.create(

model="GLM-4.7", # 可指定具体模型或使用智能路由

stream=True,

messages=[

{"role": "user", "content": "请解释Transformer架构的工作原理"}

]

)

# 处理响应

for chunk in response:

if chunk.choices[0].delta.content is not None:

print(chunk.choices[0].delta.content, end="", flush=True)3.3 智能路由调用

对于更高级的使用场景,开发者可以利用AI Ping的智能路由功能,自动选择最优模型:

import requests

# 智能路由调用示例

API_KEY = "您的AI_Ping_API密钥"

BASE_URL = "https://aiping.cn/api/v1"

payload = {

"task_type": "code_generation", # 任务类型:代码生成

"prompt": "写一个Python爬虫,爬取网页标题和正文", # 任务指令

"model_require": {

"priority": "performance_first", # 优先级:性能优先(可选price_first价格优先)

"max_tokens": 2000

}

}

headers = {"Authorization": f"Bearer {API_KEY}", "Content-Type": "application/json"}

response = requests.post(BASE_URL, json=payload, headers=headers)

if response.status_code == 200:

result = response.json()

print("生成的代码:")

print(result["data"]["code"])

print(f"\n本次使用模型:{result['model_info']['name']}")

print(f"响应耗时:{result['model_info']['response_time']}ms")

print(f"本次费用:{result['model_info']['cost']}元")3.4 免费模型使用策略

AI Ping整合了多款免费模型资源,开发者可通过以下策略最大化利用免费额度:

- 模型级联利用:优先使用免费模型,额度用尽后自动降级到次优免费模型

- 时段优化:不同时段选择不同模型,如夜间优先使用Kimi-K2(免费额度重置)

- 任务适配:根据任务类型选择专用模型,如代码生成使用MiniMax-M2

平台目前提供的免费模型包括MiniMax-M2(代码生成能力强)、GLM-4.6(逻辑推理优)和Kimi-K2-Thinking(思维链推理佳)等。

4 AI Ping的官方地址和获取方式

AI Ping主要提供在线平台服务,开发者可通过以下方式访问和使用:

- 官方网站:https://aiping.cn

- API文档:平台提供完整的API接口文档和调用示例

- 开发者社区:通过官方社区获取技术支持和最新动态

目前AI Ping主要以Web平台形式提供服务,支持通过标准API接口集成到各类应用中。平台还提供了VSCode等开发工具的插件支持,提升开发体验。

5 AI Ping vs 竞品对比分析

为了全面评估AI Ping的定位和价值,我们将其与传统选型方式及其他大模型服务平台进行对比:

5.1 与传统选型方式对比

| 特性 | 传统选型方式 | 使用AI Ping |

|---|---|---|

| 性能评估 | 基于单一测试或长期经验,缺乏实时数据支持 | 7×24小时多维度实时监测,客观数据评估 |

| API选择流程 | 手动筛选、试用多个API供应商 | 集中管理多家供应商API,自动化筛选与调用 |

| 成本管理 | 手动计算并监控,可能存在漏项 | 自动化费用追踪与分析,实时优化成本策略 |

| 服务可靠性 | 依赖供应商提供的数据和经验,无法全面评估 | 持续监测,实时揭示性能波动与服务质量问题 |

5.2 与其他模型聚合平台对比

虽然搜索结果中没有直接提到其他模型聚合平台,但基于AI Ping的核心功能,我们可以分析其独特价值:

- 评测深度:AI Ping的评测体系由清华大学和中国软件评测中心提供技术支持,具有更高的权威性和公信力

- 覆盖范围:平台已整合20余家供应商的230+模型服务,覆盖范围广泛

- 实时性:通每5分钟更新一次性能数据,确保路由决策基于最新服务能力

- 中立性:作为第三方平台,AI Ping不偏向任何特定模型供应商,保证评测结果的客观性

6 AI Ping的典型应用场景

6.1 大模型服务选型

AI Ping最核心的应用场景是帮助开发者进行大模型服务选型。例如,当企业需要为长文档分析工具选择模型时,可通过以下流程在AI Ping上完成选型:

- 确定核心需求:超长上下文支持(≥128K)、较强的摘要和归纳能力、可接受的性价比

- 使用筛选功能:在AI Ping平台上按上下文长度(选择大于64k)筛选模型

- 比较候选模型:对比剩余长文本模型的性能、价格等指标

- 选择供应商:查看各供应商的吞吐量和价格,选择处理速度快且稳定的服务商

- 最终决策:如选择DeepSeek-V3.1模型+无问芯穹服务组合

这种数据驱动的选型方式,避免了传统”试错”式选型的高成本和低效率问题。

6.2 成本敏感型批量处理

对于需要处理大量数据且对成本敏感的场景,如新闻文章批量摘要,AI Ping可帮助找到最经济的解决方案:

- 明确需求:摘要质量要求不高,但处理量巨大,成本是首要考虑因素

- 筛选策略:在AI Ping上按输出价格排序,选择最便宜的模型

- 平衡性能:从便宜模型中选择性能可接受的选项,如Qwen3-235B-A22B

- 供应商选择:在详情页的供应商列表中选择稳定性高的厂商

通过这种策略,可以最低的成本完成批量摘要任务,同时保证基本的产品质量。

6.3 智能体系统开发

在AI智能体系统开发中,AI Ping的智能路由功能可支持多模型协同工作:

- 复杂任务规划:由GLM-4.7等擅长复杂推理的模型承担任务规划

- 代码生成:由MiniMax-M2等代码生成能力强的模型实现具体功能

- 异常处理:当某个模型服务出现波动时,系统自动切换到备用节点

这种多模型协作架构,可在统一平台调度下实现高效协同,符合真实项目的工程实践需求。

7 AI Ping能为用户带来的价值

7.1 技术决策者:降低选型风险

对于技术决策者而言,AI Ping是降低选型风险的”防火墙”。平台通过客观性能数据,帮助决策者:

- 避免选型失误:基于真实数据而非厂商宣传材料做决策

- 控制项目风险:提前了解模型服务的稳定性,避免生产环境中的意外故障

- 优化资源分配:根据业务需求选择最合适的模型,避免过度投资或性能不足

据统计,企业平均需要对接3-5家模型服务商才能满足其业务需求,这种碎片化导致开发成本增加37%,上线周期延长。AI Ping的统一平台可显著降低这些间接成本。

7.2 开发者:提升开发效率

对开发者而言,AI Ping是提升集成效率的”加速器”。具体价值包括:

- 减少适配工作:统一API接口减少多平台适配工作量

- 快速原型开发:一键调用功能支持快速验证和迭代

- 调试和优化:实时性能监控帮助定位和解决集成问题

实测数据显示,使用AI Ping的智能路由平均将延迟降低20%,吞吐提升33%,验证了其效率提升效果。

7.3 企业:控制AI投入成本

对企业而言,AI Ping是控制AI投入成本的”节流阀”。平台通过以下方式帮助企业优化成本:

- 价格透明化:实时对比各供应商价格,避免隐性支出

- 免费资源利用:整合多家平台的免费额度,降低试用和开发成本

- 用量监控:实时监控API调用费用,及时发现异常开销

合理利用AI Ping的成本管理功能,企业可降低AI开发成本60%,特别适合个人开发者和初创团队。

8 AI Ping最近3到6个月内的重大功能更新

虽然搜索结果中没有明确标注各功能的具体上线时间,但基于2025年下半年的信息,我们可以总结AI Ping近期的关键发展:

8.1 免费模型资源扩展

2025年12月的信息显示,AI Ping大幅扩展了免费模型资源,新增了多款主流模型的免费体验:

- GLM-4.7体验:智谱最新旗舰模型,针对Agentic Coding与复杂智能体任务优化

- MiniMax-M2.1免费调用:聚焦多语言编程能力和代码生成稳定性

- 免费额度提升:多款模型的每日免费调用次数增加,如MiniMax-M2每日100次免费调用

这些免费资源的扩展,极大降低了开发者体验和评估模型的成本。

8.2 开发者工具集成增强

2025年底,AI Ping加强了与主流开发工具的集成,提供更无缝的开发体验:

- VSCode插件优化:Cline插件增强,支持实时API调用性能显示和成本预估

- Cursor IDE深度集成:实现代码补全时自动标注和免费模型路由

- Coze平台支持:在低代码平台中集成AI Ping路由功能

这些工具集成使开发者能够在熟悉的环境中使用AI Ping功能,提升开发效率。

8.3 智能路由算法升级

根据2025年12月的技术解析,AI Ping的智能路由算法进行了重要升级:

- 动态更新频率提升:高峰时段监测频率增加至1分钟,响应更及时

- 回滚机制优化:异常波动时自动触发回滚,保障服务连续性

- 成本预测功能:新增调用成本预测,帮助用户预算管理

这些算法升级进一步强化了AI Ping在性能优化和成本控制方面的优势。

9 常见问题FAQ解答

9.1 AI Ping是如何保证评测数据准确性的?

AI Ping的评测数据由清华大学和中国软件评测中心提供技术支持,确保权威性和准确性。平台通过自动化的长周期、高频次测试,监测吞吐量、延迟、稳定性等维度,24小时跟踪数据波动,确保数据的全面性和客观性。所有性能数据均为真实跑分+线上调用统计,非理论值或厂商宣传数据。

9.2 AI Ping的收费模式是怎样的?

AI Ping本身提供免费的性能评测和模型对比服务。当用户通过平台调用大模型API时,需要支付相应的模型使用费用,但AI Ping不额外收取服务费。平台还通过邀请机制提供奖励金(好友注册成功后,邀请双方各获得20元平台奖励金),可用于抵扣调用成本。

9.3 如何最大化利用AI Ping的免费资源?

要最大化利用AI Ping的免费资源,可以采取以下策略:

- 模型级联:优先使用免费模型,额度用尽后自动降级到次优免费模型

- 时段优化:不同时段选择不同模型,如夜间优先使用Kimi-K2

- 任务适配:根据任务类型选择专用模型,如代码生成使用MiniMax-M2

- 邀请奖励:通过邀请好友增加平台奖励金,延长免费使用时长

9.4 AI Ping是否支持企业级定制需求?

AI Ping的愿景不仅是”评测工具”,而是成为企业AI效能管理的中枢。平台已有下一步规划包括:AI效能看板(集成模型性能、成本、合规性数据)和自动优化引擎(基于评测结果自动调整模型参数)等企业级功能。这些功能将支持更复杂的企业定制需求。

9.5 如果遇到模型服务不稳定,AI Ping如何应对?

AI Ping的智能路由引擎包含异常处理机制。当检测到某供应商延迟激增或吞吐骤降时,系统会自动降权或切换备用节点,保障服务连续性。这种自动故障转移机制确保即使单个模型服务出现问题时,整体服务仍能保持稳定。

10 总结

AI Ping作为大模型服务评测与API调用平台,在当前大模型应用生态中找到了精准定位:不制造模型,但让模型真正”可用、好用、敢用”。通过一站式的模型评测与API调用能力,平台为开发者提供了低门槛、高价值的实践环境。 核心价值总结:

- 数据驱动决策:通过7×24小时实时性能监测,打破信息壁垒,用量化数据替代主观判断

- 工程友好设计:统一API设计和丰富的工具集成,显著降低开发门槛和集成成本

- 成本优化优势:智能路由和免费资源整合,可降低AI开发成本60%

- 生态中立定位:作为第三方平台,提供客观、中立的评测结果

随着大模型技术的持续迭代,选型的复杂度将进一步提升,而AI Ping这类中立、客观的决策支持平台,必将成为连接模型厂商与终端用户的核心桥梁,推动AI应用从”盲目选型”走向”精准落地”。 对于正在寻找可以高效评测模型、快速落地工程实践,并兼顾成本控制的平台的开发者,AI Ping无疑是一个值得深入体验的选择。通过实际使用体验,开发者将更能感受到其在模型选型、性能优化和成本控制方面的独特价值。

参考文章或数据来源

本文综合参考了以下权威平台和机构发布的信息,确保内容的专业性和可靠性:

- 《AI Ping 大模型服务评测平台:解锁大模型效能的“性能罗盘”》 – 火山引擎开发者社区(2025年09月18日)

- 《薅羊毛也要讲技术:AI Ping 平台免费体验 GLM-4.7 与 MiniMax-M2.1》 – CSDN博客(2025年12月24日)

- 《AIPing平台深度评测与主流大模型性能对比》 – 阿里云开发者社区(2025年09月17日)

- 《AI Ping 深度测评:聚合模型 + 免费编程工具,开发者的效率神器与薅羊毛指南》 – CSDN博客(2025年12月10日)

- 《告别MaaS模型选型困难:AI Ping为大模型服务选型提供精准性能评测排行榜》 – 百度百家号(2025年09月17日)

- 《AI Ping: 一站式大模型服务评测与API调用平台技术解析》 – 阿里云开发者社区(2025年12月10日)

- 《AI Ping 深度评测:大模型 API 选型的 “理性决策中枢”》 – 阿里云开发者社区(2025年12月09日)

引用总结:本文引用了火山引擎开发者社区、阿里云开发者社区、CSDN博客和百度百家号等内容,数据来自清华大学和中国软件评测中心等权威机构,确保文章的专业性与可靠度。

最新更新日期:2026年01月07日

数据统计

更多AI产品信息

AI Ping

已有 182 次访问体验

已收录

申请修改

AI Ping的官网地址是?

AI Ping的官网及网页版入口是:https://aiping.cn/ 官网入口👈

网站流量数据说明

网站数据仅供参考。评估因素包括访问速度、搜索引擎收录、用户体验等。 如需获取详细数据(如IP、PV、跳出率等),请联系站长获取。

推荐数据源

爱站/AITDK

关于AI Ping的特别声明

AI产品库AIProductHub是一个专注于AI产品收录与分享的网站平台,平台收录了1000余款AI产品,覆盖创作、办公、编程、视频生成、电商、设计、写作、图像生成等多个领域和行业,平台旨在帮助更多的用户发现更好用的AI产品。本站【AI产品库AIProductHub】提供的【AI Ping】信息来源于网络。 对于该外部链接的指向,不由【AI产品库AIProductHub】实际控制。【AI Ping】在【2026-01-07 19:56】收录时, 该网页内容属于合规合法,后期如出现违规内容,可直接联系网站管理员删除,【AI产品库AIProductHub】不承担任何责任。

本文地址:https://aiproducthub.cn/sites/ai-ping.html 转载请注明来源

相关导航

Base44是一款AI驱动的零代码平台,用户只需用自然语言描述需求,即可自动生成并部署具备完整前后端功能的Web应用程序。

美间AI

美间AI是一款智能设计工具,可10秒生成商品图、全屋效果图和营销文案,大幅提升电商设计效率。

Nano BananaAI Image Editor

Nano Banana是一款基于Google Gemini的AI图像编辑工具,能通过自然语言指令实现精准的局部修改并保持角色一致性。

DINQ

DINQ是一款智能AI人才引擎平台,通过多模态数据采集与分析,为AI人才评估建立全新标准。

夸克AIPPT

夸克AI PPT是一款基于自研大模型的智能演示文稿生成工具,可一键生成专业级PPT,大幅提升制作效率。

办公小浣熊

Raccoon - Another Comprehensive CO-pilOt Navigator | Raccoon是基于商汤自研大语言模型的智能助手,包含代码助手、办公助手,满足用户代码编写、数据分析、编程学习等各类需求。

艾绘

艾绘 - 一站式绘本创作平台

通义万相2.6系列

通义万相2.6是阿里发布的AI视频模型,支持用户上传照片或视频快速生成带有本人形象和音色的角色扮演短片,实现“人人皆可当主角”。

您必须登录才能参与评论!

立即登录

界面清爽,找功能不费劲,新手友好。

智能路由真管用,延迟降了不少,省心。

免费额度用完能自动切换吗?

成本控制帮大忙,省了一半开销,推荐给团队。