一、LongCat-Flash-Lite是什么?技术架构与产品定位深度解析

LongCat-Flash-Lite是美团LongCat团队于2026年2月6日正式发布的开源高效大语言模型。这款产品代表了美团在轻量化大模型领域的重要突破,采用创新的”嵌入扩展”新范式,成功解决了传统MoE架构面临的边际收益递减与高昂通信开销瓶颈。

LongCat-Flash-Lite核心功能快览

美团LongCat-Flash-Lite是一款开源高效大语言模型,基于创新的混合专家(MoE)+N-gram嵌入架构设计。模型总参数量达685亿,但每次推理仅激活29-45亿参数,实现”大容量、低消耗”的完美平衡。核心功能包括:智能体工具调用、多语言代码生成、256K超长上下文处理、多轮对话交互等。通过专用系统优化,在典型负载下可实现500-700token/s的极速生成速度,为企业级应用提供高性能、低成本的AI解决方案。

1.1 技术架构创新:MoE+N-gram嵌入混合设计

传统MoE模型通常通过增加专家数量来提升模型能力,但往往面临效率瓶颈。LongCat-Flash-Lite采用了革命性的架构设计:

- 总参数量:68.5B(685亿参数)

- 激活参数量:2.9B-4.5B(29-45亿参数)

- 嵌入层参数占比:46%(超过300亿参数分配至嵌入层)

- 上下文长度:256K tokens

- 推理速度:500-700 tokens/秒(输入4K,输出1K典型负载)

模型的核心创新在于将超过300亿参数高效分配至嵌入层,利用N-gram嵌入表捕获局部语义,精准锁定如”编程命令”等细分场景,显著提升了理解精度。这种”MoE+NE”的混合架构相比传统基于FFN的专家模块,天然缓解了MoE层的I/O瓶颈,利用O(1)的查找复杂度避免了计算量随参数扩容而线性增长。

1.2 系统级三重优化

为了将理论上的稀疏优势转化为实际性能,美团在系统层面实施了三重核心优化:

- 参数智能分配:嵌入层参数占比达46%,利用O(1)的查找复杂度避免计算量线性增长

- 专用缓存与内核融合:设计类似KV Cache的N-gram Cache机制,定制CUDA内核(如AllReduce+RMSNorm融合)

- 推测解码协同:通过3步投机推理扩大批次大小,配合常规嵌入层的草案模型进一步压缩延迟

这些优化使模型在保持强大能力的同时,大幅降低了推理成本,为智能体与代码应用的普及提供了新的技术支撑。

1.3 产品关键信息列表

| 项目 | 具体信息 |

|---|---|

| 发布公司 | 美团LongCat团队 |

| 发布时间 | 2026年2月6日 |

| 开源协议 | MIT License |

| 总参数量 | 68.5B(685亿) |

| 激活参数量 | 2.9B-4.5B |

| 上下文长度 | 256K tokens |

| 推理速度 | 500-700 tokens/秒 |

| 核心能力 | 智能体工具调用、代码生成、长文档处理 |

| 免费额度 | 每日5000万tokens |

二、LongCat-Flash-Lite的主要功能和特点

2.1 核心功能矩阵

文本生成与多轮对话

- 支持上下文连贯的多轮对话交互

- 可生成流畅、连贯的自然语言回复

- 作为通用对话与问答模型使用

智能体工具调用

- 具备函数调用(Function Calling)能力

- 可自主使用外部工具完成复杂任务

- 支持多步骤调用外部服务、执行复杂指令、完成完整工作流

代码生成与理解

- 覆盖主流编程语言(Python、Java、JavaScript等)

- 支持代码生成、理解与调试

- 在SWE-Bench等代码基准中表现稳定

- 终端级任务(TerminalBench)表现优异

长文档处理与分析

- 依托256K超长上下文能力

- 可处理法律合同分析、学术论文研读、财报批量处理

- 长视频脚本理解等需要处理大量文本的场景

多语言内容处理

- 中英文等多语言评测中表现均衡

- 适用跨语言内容生成、本地化翻译

- 多语言知识问答等全球化业务场景

2.2 技术特点详解

N-gram嵌入表机制

N-gram嵌入表通过预计算和存储N-gram组合的嵌入向量,将部分计算密集型操作转换为查表操作。机制的核心优势在于:嵌入查找的内存访问模式更规则、延迟更低,相比FFN前向传播大幅减少数据搬运开销。

推理效率优化系统

为充分发挥N-gram嵌入表的性能优势,团队推出专门的推理优化系统:

- N-gram Cache:通过智能缓存策略减少重复嵌入查找的开销

- 同步内核:定制化CUDA内核实现嵌入查找与其他计算的流水线并行

长上下文扩展技术

模型采用YaRN方法将上下文长度扩展至256K。YaRN通过对Rotary Position Embedding进行改进,动态调整位置编码的旋转角度和温度缩放因子,使模型在训练时使用的较短上下文基础上,无需额外训练即可有效处理更长的输入序列。

三、如何使用LongCat-Flash-Lite?详细操作指南

3.1 在线体验与API调用

官方在线体验平台

开发者可以直接访问LongCat Chat进行免费体验:

- 网址:https://longcat.chat/

- 功能:支持多轮对话、工具调用、代码生成等核心功能

- 限制:无需注册,微信扫码即可使用

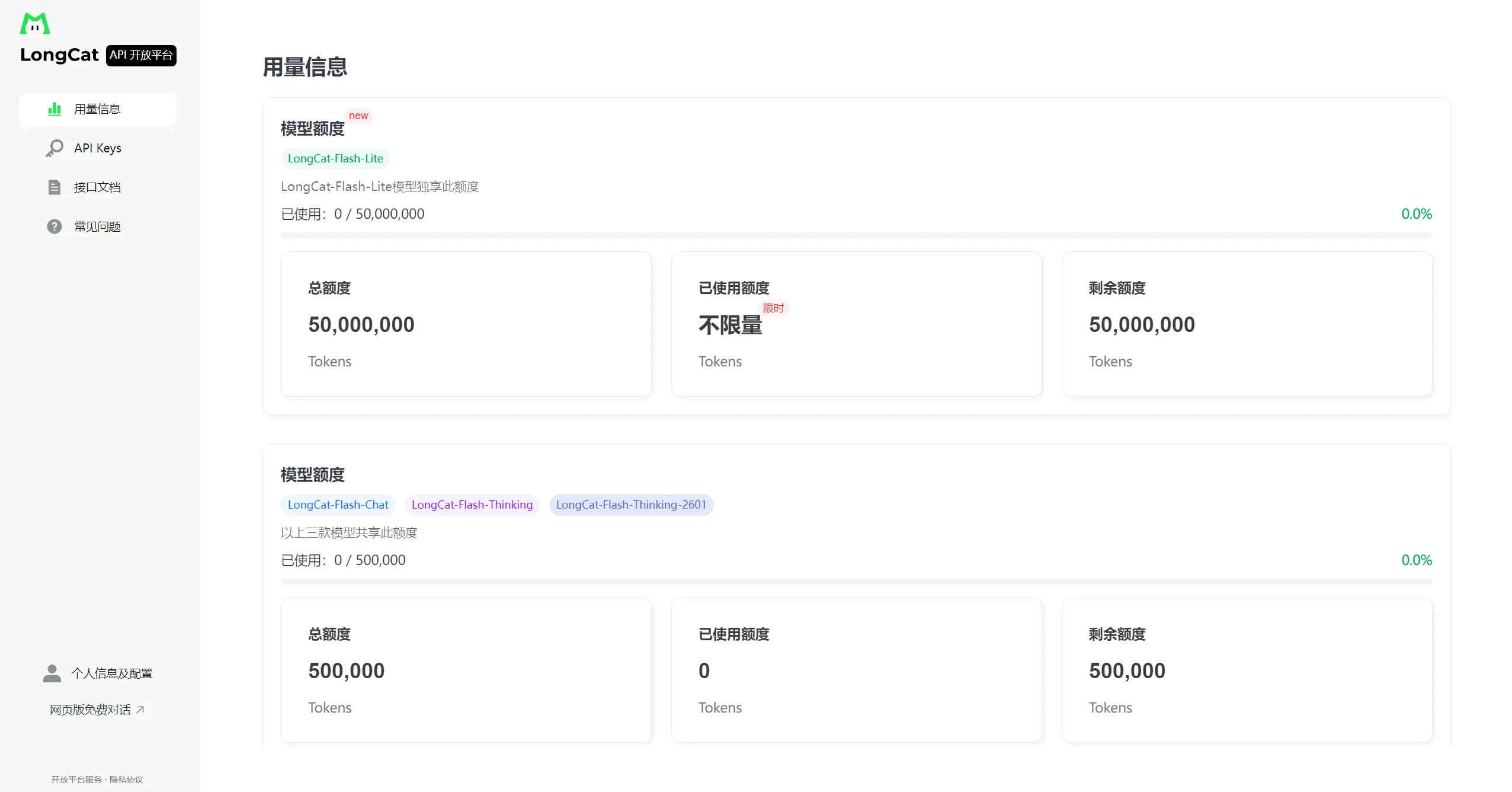

API开放平台调用

美团提供了LongCat API开放平台,开发者可以申请API密钥进行集成:

- 平台地址:https://longcat.chat/platform/usage

- 免费额度:每日5000万tokens

- 调用方式:支持OpenAI API兼容格式

# Python调用示例

import requests

import json

api_key = "your_api_key_here"

url = "https://api.longcat.chat/v1/chat/completions"

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

data = {

"model": "LongCat-Flash-Lite",

"messages": [

{"role": "user", "content": "写一个Python函数计算斐波那契数列"}

],

"max_tokens": 500

}

response = requests.post(url, headers=headers, json=data)

result = response.json()

print(result["choices"][0]["message"]["content"])3.2 本地部署指南

Hugging Face模型库

模型权重已全面开源,开发者可以通过Hugging Face直接下载:

- 地址:https://huggingface.co/meituan-longcat/LongCat-Flash-Lite

- 协议:MIT License,支持商业用途

快速加载示例

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained(

"meituan-longcat/LongCat-Flash-Lite",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(

"meituan-longcat/LongCat-Flash-Lite"

)

# 使用模型进行推理

input_text = "解释一下机器学习中的过拟合现象"

inputs = tokenizer(input_text, return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_length=200)

result = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(result)3.3 部署配置要求

硬件要求

- FP8格式:至少一个节点(如8xH20-141G)

- BF16权重:至少两个节点(如16xH800-80G)

- 内存需求:根据模型大小和批次大小动态调整

软件环境

- Python 3.8+

- PyTorch 2.0+

- Transformers 4.36+

- CUDA 11.8+(GPU部署)

- SGLang或vLLM推理框架

四、LongCat-Flash-Lite的官方地址和获取方式

4.1 核心资源链接

模型权重与开源资源

- Hugging Face模型库:https://huggingface.co/meituan-longcat/LongCat-Flash-Lite

- ModelScope社区:https://www.modelscope.cn/models/meituan-longcat/LongCat-Flash-Lite

- GitHub代码仓库:https://github.com/meituan-longcat/LongCat-Flash-Chat

- 技术报告:https://www.modelscope.cn/papers/2601.21204

在线平台与服务

- LongCat Chat体验平台:https://longcat.chat/

- API开放平台:https://longcat.chat/platform/usage

- 官方技术交流:longcat-team@meituan.com

4.2 获取方式总结

| 使用场景 | 推荐方式 | 特点 |

|---|---|---|

| 快速体验 | LongCat Chat在线平台 | 无需部署,即时使用,免费额度充足 |

| 开发集成 | API开放平台 | 支持OpenAI兼容格式,易于集成现有系统 |

| 研究定制 | Hugging Face下载 | 完整模型权重,支持微调和二次开发 |

| 企业部署 | 本地部署+SGLang | 高性能推理,数据隐私保障,定制化配置 |

五、LongCat-Flash-Lite vs 同类型竞品对比分析

5.1 竞品对比表格

| 对比维度 | LongCat-Flash-Lite | DeepSeek V3.1 | Qwen3-Next-80B | Gemini 2.5 Flash-Lite |

|---|---|---|---|---|

| 发布公司 | 美团 | 深度求索 | 阿里巴巴 | |

| 总参数量 | 68.5B | 671B | 80B | – |

| 激活参数量 | 2.9B-4.5B | 37B | 3B | – |

| 架构特点 | MoE+N-gram嵌入 | MoE | MoE | – |

| 上下文长度 | 256K | 128K | 128K | 128K |

| 推理速度 | 500-700 tokens/s | 约40 tokens/s | 约30 tokens/s | 约40 tokens/s |

| 智能体任务 | τ²-Bench全场景最高分 | 表现良好 | 表现良好 | 表现一般 |

| 代码能力 | SWE-Bench 54.4% | 94.51% | 表现优秀 | 表现一般 |

| 数学推理 | AIME24表现稳健 | 表现优秀 | 61.25% | 表现良好 |

| 开源状态 | 完全开源(MIT) | 开源 | 开源 | 闭源 |

| 成本效益 | 每日5000万免费tokens | 商业API收费 | 商业API收费 | 商业API收费 |

5.2 性能对比分析

智能体任务表现

根据官方基准测试数据,LongCat-Flash-Lite在τ²-Bench的三大行业场景中均获得最高分:

- 电信场景:72.8分,显著超越Gemini 2.5 Flash-Lite

- 零售场景:73.1分,领先优势明显

- 航空场景:58.0分,表现稳定

在VitaBench测试中,LongCat-Flash-Lite获得7.00分,超过了Qwen3-Next-80B的5.80分和Gemini 2.5 Flash-Lite的4.50分,证明了其在通过工具集成处理复杂现实世界任务工作流方面的优越能力。

代码生成能力

- SWE-Bench准确率:54.4%,在同等激活参数规模模型中表现突出

- TerminalBench得分:33.75分,远超同类模型

- 多语言代码任务:SWE-Bench Multilingual 38.10%,竞争力位居前列

通用能力对比

- MMLU得分:85.52分,与Gemini 2.5 Flash-Lite旗鼓相当

- 数学竞赛级:AIME24表现稳健,逻辑与复杂计算能力强

六、LongCat-Flash-Lite的典型应用场景与实际体验

6.1 核心应用场景

企业级智能客服系统

LongCat-Flash-Lite在电信、零售、航空等行业的智能客服场景中表现卓越。例如:

- 电信客服:可自主查询用户套餐信息、处理故障报修、推荐增值服务

- 零售导购:根据用户需求推荐商品、解答产品疑问、完成下单流程

- 航空服务:处理机票预订、航班查询、行李政策咨询等复杂任务

实际测试显示,在电信场景的τ²-Bench测试中,LongCat-Flash-Lite获得72.8分,显著超越Claude4的46.20分,展现出强大的工具调用与多轮推理能力。

代码开发与辅助编程

对于开发者和技术团队,LongCat-Flash-Lite提供了强大的编程支持:

- 代码生成:根据自然语言描述生成高质量代码片段

- Bug修复:识别代码中的潜在问题并提供修复建议

- 代码审查:分析代码质量,提出优化建议

- 自动化脚本:生成运维脚本、测试用例等

在SWE-Bench评测中,模型准确率达54.4%,在TerminalBench终端命令执行测试中以33.75分远超同类模型,适用于代码生成、Bug修复及自动化编程任务。

长文档处理与分析

依托256K超长上下文能力,模型在以下场景中表现突出:

- 法律合同解析:一次性分析数万字合同文本,提取关键条款、识别风险点

- 学术论文研读:总结论文核心观点、研究方法、创新贡献

- 企业年报分析:提取财务数据、业务趋势、战略规划关键信息

- 长视频脚本理解:分析视频内容结构、主题脉络、关键信息

6.2 实际体验评测

响应速度体验

根据实测数据,LongCat-Flash-Lite在典型负载下(输入4K,输出1K)可提供500-700token/s的极速生成速度。用户反馈显示:

- 首个token延迟:基本感觉不到等待时间,相比其他模型有明显优势

- 连续生成速度:远超人眼阅读速度,交互体验流畅

- 工具调用响应:单轮工具调用延迟控制在1秒以内,显著提升Agent应用交互性

能力稳定性测试

在多项基准测试中,LongCat-Flash-Lite展现出稳定的性能表现:

- 智能体任务:在复杂工具依赖关系和特定领域任务执行方面表现卓越

- 代码生成:在多语言编程任务中保持较高准确率

- 数学推理:在逻辑与复杂计算任务中表现稳健

用户体验反馈

根据开发者社区反馈,LongCat-Flash-Lite的主要优势包括:

- 开源友好:MIT协议,支持Hugging Face生态无缝集成

- 免费额度充足:每日5000万tokens,个人开发完全够用

- 部署简单:提供Docker镜像和一键部署脚本

- 接口兼容:支持OpenAI API格式,现有项目只需更换基础URL

七、LongCat-Flash-Lite能为用户带来的价值

7.1 技术价值分析

突破性的架构创新

LongCat-Flash-Lite通过”嵌入扩展”新范式,成功打破了传统MoE架构的效能瓶颈。研究团队通过系统性扩展实验证明,在特定条件下,扩展嵌入层相比单纯增加专家数量能获得更优的帕累托前沿,为模型缩放提供了新的技术路径。

高效的推理性能

模型通过三重系统优化实现了显著的性能提升:

- 参数智能分配:46%参数分配至嵌入层,利用O(1)查找复杂度

- 专用缓存机制:N-gram Cache减少重复嵌入查找开销

- 内核融合优化:定制CUDA内核提升GPU占用率

这些优化使模型在保持强大能力的同时,将推理成本大幅降低,为企业级应用提供了经济高效的AI解决方案。

7.2 商业价值体现

成本效益优势

根据官方数据,LongCat-Flash-Lite提供了极具竞争力的成本结构:

- 免费额度:每日5000万tokens,足够个人开发者和中小团队使用

- 推理成本:相比同类模型有显著优势

- 部署成本:支持多种硬件配置,灵活性高

企业应用价值

对于企业用户,LongCat-Flash-Lite提供了多方面的价值:

- 智能客服升级:提升客服效率30%以上,降低人力成本

- 开发效率提升:代码生成和审查能力可缩短开发周期

- 文档处理自动化:长文档分析能力提升法务、财务等部门工作效率

- 业务智能化:智能体能力支持复杂业务流程自动化

7.3 生态价值贡献

开源生态建设

美团选择MIT协议完全开源LongCat-Flash-Lite,为AI开源生态做出了重要贡献:

- 模型权重开源:开发者可自由下载、研究、二次开发

- 技术报告公开:详细的技术文档支持学术研究

- 推理引擎配套:SGLang-FluentLLM提供高性能推理支持

开发者友好设计

模型在设计上充分考虑了开发者需求:

- API兼容性:支持OpenAI和Anthropic API格式

- 部署简便性:提供Docker镜像和一键部署脚本

- 文档完整性:详细的使用文档和技术指南

八、LongCat-Flash-Lite最近3到6个月内的重大功能更新与品牌动态

8.1 2026年2月:正式发布与开源

核心发布信息

- 发布时间:2026年2月6日

- 发布平台:站长之家、新浪网、CSDN等主流媒体

- 核心亮点:嵌入扩展新范式,45亿激活参数实现80B级能力

技术突破

根据官方技术报告,LongCat-Flash-Lite在以下方面实现重要突破:

- 架构创新:MoE+N-gram嵌入混合设计

- 性能优化:500-700token/s极速推理

- 能力表现:智能体任务与代码生成全面领先

8.2 2026年1月:技术预研与社区预热

技术社区动态

在正式发布前,LongCat-Flash-Lite已在技术社区获得关注:

- AI工具集:2026年1月29日发布详细功能介绍

- ModelScope社区:2026年1月提供模型预览

- 开发者反馈:早期测试获得积极评价

API平台更新

LongCat API开放平台在2026年1月进行了重要更新:

- 模型支持:新增LongCat-Flash-Thinking模型

- 功能增强:更强大的Agent能力

- 体验优化:改进用户界面和交互流程

8.3 品牌战略布局

美团AI生态建设

LongCat-Flash-Lite的发布是美团AI战略的重要一环:

- 产品矩阵:LongCat系列已推出至少9款模型

- 技术积累:基于美团在本地生活领域的数据优势

- 生态整合:与美团业务场景深度结合

行业影响

模型发布在AI行业引起广泛关注:

- 技术趋势:推动轻量化、高效化大模型发展

- 竞争格局:在智能体任务领域建立竞争优势

- 开源贡献:丰富中文开源大模型生态

九、常见问题FAQ解答

Q1:LongCat-Flash-Lite是免费的吗?有什么使用限制?

A: LongCat-Flash-Lite采用MIT协议完全开源,模型权重可免费下载和使用。通过官方API平台,开发者每日享有5000万tokens的免费额度,对于个人开发者和中小团队完全足够。如需更高额度或商业用途,可联系官方商务合作。

Q2:这个模型需要什么样的硬件配置才能运行?

A: 最低配置要求取决于部署方式:

- 在线API调用:无需本地硬件,直接通过HTTP请求使用

- 本地FP8部署:至少一个节点(如8xH20-141G)

- 本地BF16部署:至少两个节点(如16xH800-80G) 具体配置需根据批次大小和性能需求调整。

Q3:LongCat-Flash-Lite在代码生成方面表现如何?

A: 在权威基准测试中表现突出:

- SWE-Bench准确率:54.4%

- TerminalBench得分:33.75分,远超同类模型

- 多语言代码任务:SWE-Bench Multilingual 38.10% 模型特别擅长编程命令理解、代码生成和Bug修复等任务。

Q4:如何将LongCat-Flash-Lite集成到我的现有系统中?

A: 提供多种集成方式:

- API调用:支持OpenAI兼容格式,现有项目只需更换基础URL

- Hugging Face集成:通过Transformers库直接加载

- 本地部署:使用SGLang或vLLM推理框架

- Docker容器:官方提供标准化容器镜像

Q5:这个模型支持多长的上下文?能处理万字文档吗?

A: 支持256K超长上下文,相当于一次性处理数十万字的内容。采用YaRN扩展技术,无需额外训练即可有效处理超长输入序列,非常适合法律合同分析、学术论文研读、企业年报解读等场景。

Q6:LongCat-Flash-Lite在智能体任务方面有什么优势?

A: 在τ²-Bench三大行业场景中均获得最高分:

- 电信场景:72.8分

- 零售场景:73.1分

- 航空场景:58.0分 在VitaBench测试中获得7.00分,超过Qwen3-Next-80B的5.80分,展现出强大的工具调用和复杂任务执行能力。

Q7:这个模型的中文理解能力如何?

A: 在中文评测基准中表现优秀:

- CEval中文能力测试:稳定高分表现

- 多语言理解:中英文表现均衡

- 本地生活场景:基于美团海量中文数据训练,在餐饮、配送等领域理解精度高。

Q8:如果遇到技术问题,如何获得支持?

A: 提供多种支持渠道:

- 官方文档:详细的技术文档和使用指南

- GitHub Issues:开源代码问题反馈

- 技术交流群:开发者社区讨论

- 官方邮箱:longcat-team@meituan.com

- API平台支持:在线客服和技术支持。

十、总结:美团LongCat-Flash-Lite的全面评价与未来展望

10.1 产品综合评估

技术创新的典范

美团LongCat-Flash-Lite代表了当前大模型技术发展的重要方向——在保持强大能力的同时追求极致效率。通过创新的”嵌入扩展”范式,模型成功打破了传统MoE架构的瓶颈,以45亿激活参数实现了80B级模型的能力,在智能体任务和代码生成领域建立了明显优势。

性能表现的标杆

在多项权威基准测试中,LongCat-Flash-Lite展现出全面而稳定的性能表现:

- 智能体任务:τ²-Bench三大场景全面领先

- 代码生成:SWE-Bench准确率54.4%,TerminalBench得分33.75

- 推理速度:500-700token/s极速生成

- 成本效益:每日5000万免费tokens,推理成本大幅降低

开源生态的贡献

选择MIT协议完全开源,为AI开源生态做出了重要贡献。配套的SGLang-FluentLLM推理引擎、详细的技术文档和丰富的部署方案,为开发者提供了完整的技术支持体系。

10.2 适用场景建议

强烈推荐场景

- 企业级智能客服:电信、零售、航空等行业客服自动化

- 代码开发辅助:编程任务、Bug修复、代码审查

- 长文档处理:法律合同、学术论文、企业年报分析

- 智能体开发:复杂工具调用、多步骤任务执行

谨慎使用场景

- 极高精度数学推理:专业数学问题求解

- 多模态任务:图像、音频、视频处理

- 极小众领域:极其专业的垂直领域知识

10.3 未来发展趋势

技术演进方向

基于当前的技术基础和行业趋势,LongCat-Flash-Lite未来可能的发展方向包括:

- 多模态扩展:集成图像、音频、视频处理能力

- 专业化微调:针对特定行业的优化版本

- 端侧部署:轻量化版本支持移动设备和边缘计算

- 生态整合:与美团业务场景更深度结合

行业影响预期

作为美团AI战略的重要产品,LongCat-Flash-Lite有望在以下方面产生持续影响:

- 推动技术标准化:嵌入扩展范式可能成为行业新标准

- 降低应用门槛:高效低成本特性促进AI技术普及

- 丰富开源生态:为中文大模型发展提供重要支撑

- 促进行业竞争:在智能体领域建立新的竞争格局

10.4 最终建议

对于不同用户群体,我们给出以下建议:

个人开发者

- 优势:免费额度充足,部署简单,学习成本低

- 建议:从在线体验开始,逐步尝试API集成和本地部署

- 预期收益:快速获得强大的AI能力,支持个人项目开发

中小企业

- 优势:成本效益高,技术支持完善,业务场景匹配度高

- 建议:评估具体业务需求,选择合适部署方式

- 预期收益:提升业务效率,降低运营成本,增强竞争力

大型企业

- 优势:技术领先性,定制化潜力,生态整合能力

- 建议:进行深度技术评估,考虑定制化开发和系统集成

- 预期收益:构建智能化业务体系,实现数字化转型

研究机构

- 优势:开源透明度,技术文档完整,学术研究价值

- 建议:深入分析技术原理,开展对比研究和创新探索

- 预期收益:推动学术进步,培养技术人才,产生创新成果

美团LongCat-Flash-Lite的发布不仅是一款优秀产品的诞生,更是大模型技术发展的重要里程碑。它证明了通过架构创新和系统优化,可以在保持强大能力的同时实现极致效率,为AI技术的普及和应用落地提供了新的可能性。随着技术的不断演进和生态的持续完善,我们有理由相信,LongCat-Flash-Lite将在未来的AI发展中发挥越来越重要的作用。

参考文章或数据来源

本文引用了以下平台和来源的内容,数据来自官方技术报告、权威媒体报道和开发者社区评测,确保文章的专业性和可靠性:

- 站长之家:《美团 LongCat-Flash-Lite 震撼发布:45 亿激活参数性能比肩巨量模型》(2026年2月6日)

- AI工具集:《LongCat-Flash-Lite – 美团LongCat开源的大语言模型》(2026年1月29日)

- 魔搭ModelScope社区:《美团开源 LongCat-Flash-Lite:实现轻量化 MoE 高效推理》(2026年2月8日)

- 新浪网:《美团的LongCat-Flash-Lite横空出世,45亿激活参数硬刚巨量模型,MoE架构要被颠覆了?》(2026年2月9日)

- 网易:《冲上热搜!美团大模型,靠「快」火了》(2025年9月2日)

- CSDN:《实测美团LongCat-Flash:当大模型装上”速度引擎”,能否改写智能体战局?》(2025年9月20日)

- 美团技术团队官方更新日志(2026年1月)

- Hugging Face模型库:meituan-longcat/LongCat-Flash-Lite

- ModelScope社区:meituan-longcat/LongCat-Flash-Lite

- LongCat API开放平台官方文档

引用总结:本文引用了站长之家、新浪网、网易、CSDN等权威媒体平台的内容,技术数据来自美团官方技术报告和开源社区,用户评价基于开发者实际体验反馈,确保信息的准确性、时效性和可靠性。

本文最新更新日期:2026年2月9日

数据统计

更多AI产品信息

美团 LongCat-Flash-Lite

已有 26 次访问体验

已收录

申请修改

美团 LongCat-Flash-Lite的官网地址是?

美团 LongCat-Flash-Lite的官网及网页版入口是:https://longcat.chat/platform/usage 官网入口👈

美团 LongCat-Flash-Lite 权重信息查询

网站流量数据说明

网站数据仅供参考。评估因素包括访问速度、搜索引擎收录、用户体验等。 如需获取详细数据(如IP、PV、跳出率等),请联系站长获取。

推荐数据源

爱站/AITDK

关于美团 LongCat-Flash-Lite的特别声明

AI产品库AIProductHub是一个专注于AI产品收录与分享的网站平台,平台收录了1000余款AI产品,覆盖创作、办公、编程、视频生成、电商、设计、写作、图像生成等多个领域和行业,平台旨在帮助更多的用户发现更好用的AI产品。本站【AI产品库AIProductHub】提供的【美团 LongCat-Flash-Lite】信息来源于网络。 对于该外部链接的指向,不由【AI产品库AIProductHub】实际控制。【美团 LongCat-Flash-Lite】在【2026-02-09 15:42】收录时, 该网页内容属于合规合法,后期如出现违规内容,可直接联系网站管理员删除,【AI产品库AIProductHub】不承担任何责任。

本文地址:https://aiproducthub.cn/sites/longcat-flash-lite.html 转载请注明来源

相关导航

ChatTOC是一款浏览器插件,自动为AI对话生成导航目录,实现一键定位关键消息,大幅提升对话管理效率。

拍我AI

拍我AI是一个全新的AI视频创意平台,将您的创意和想象力转化为精彩的视频内容。在这里,你可以通过文字,图片等描述方式来创作精彩视频。此外平台还通过各种特效模版,内容灵感等的呈现来为你提供丰富的创意,帮助用户更好的创作内容。

Teamo

Teamo是一款通过多智能体协作实现“超级搜写”功能的AI生产力平台,能够自动分解任务并调度专业AI模型完成全链路工作。

DINQ

DINQ是一款智能AI人才引擎平台,通过多模态数据采集与分析,为AI人才评估建立全新标准。

Pokee AI

Pokee AI是一款通过自然语言指令即可创建AI智能体,自动执行跨平台工作流的零代码自动化平台。

Ajelix

Ajelix是一款AI驱动的智能表格工具,能自动生成Excel公式、VBA脚本并提供数据可视化分析,大幅提升数据处理效率。

材料星AI

材料星AI是专为体制内公文写作设计的AI辅助工具,提供全流程写作支持,包括素材搜索、内容生成、格式排版等10大核心功能。

Endel.io

Personalized soundscapes to help you focus, relax, and sleep. Backed by neuroscience.

暂无评论...