华为Flex:ai全面开源,AI容器技术如何将GPU利用率提升至70%?

1 Flex:ai是什么?

华为Flex:ai是基于Kubernetes容器编排平台构建的AI容器技术,于2025年11月21日在上海举办的”2025 AI容器应用落地与发展论坛”上正式发布。这一技术旨在解决当前AI产业面临的算力资源严重浪费问题。 根据行业数据,当前全球算力资源平均利用率仅为30%-40%,大量算力处于闲置状态。

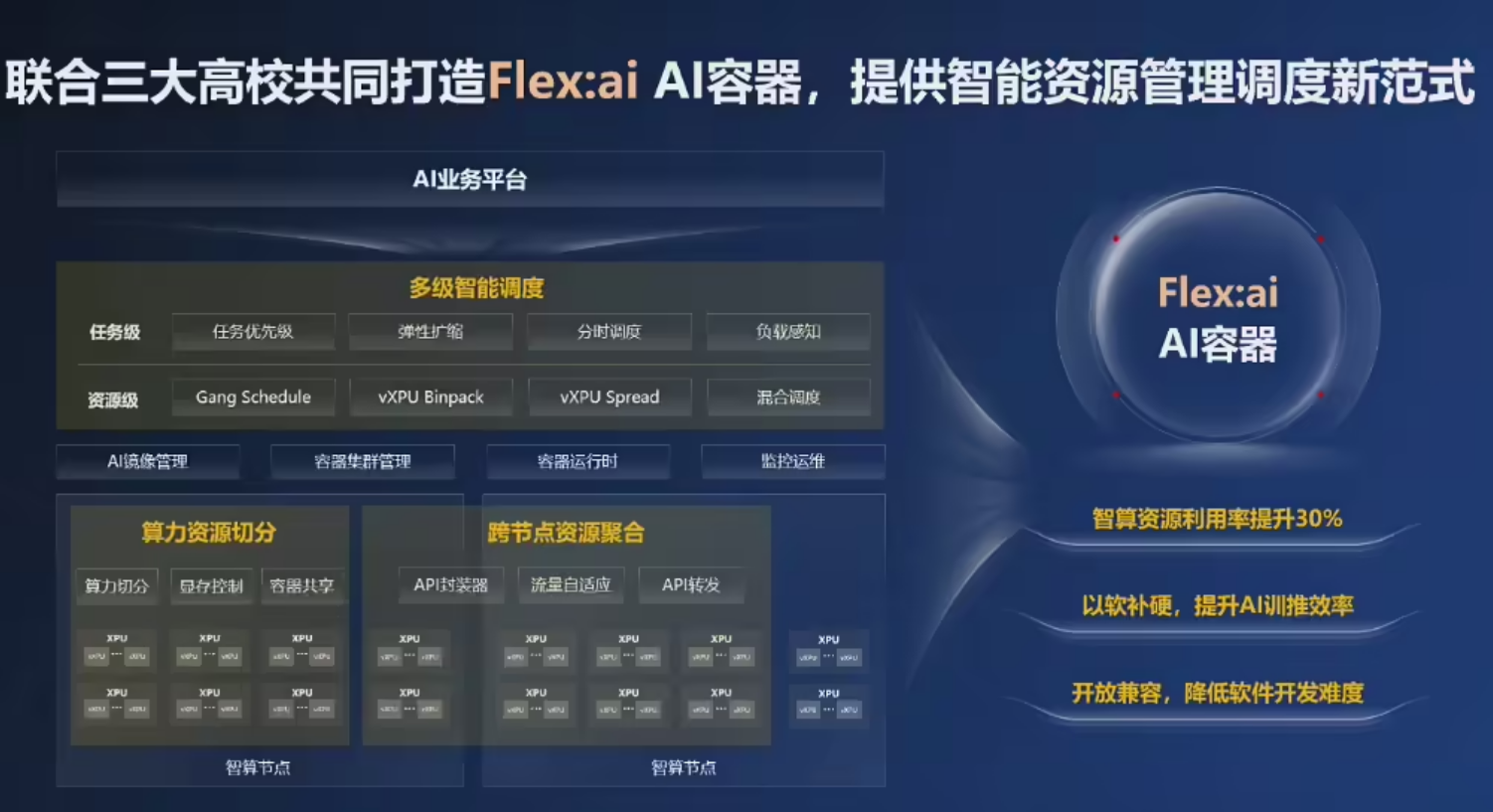

小模型任务独占整卡导致资源闲置,大模型任务单机算力不足难以支撑,大量缺乏GPU/NPU的通用服务器更是处于算力”休眠”状态。Flex:ai通过精细化的资源管理与智能调度,能够将算力利用率提升至70%,相当于在不增加硬件投资的情况下实现算力翻倍。 值得一提的是,Flex:ai是华为与上海交通大学、西安交通大学和厦门大学三所高校联合研发的成果,并已宣布全面开源至魔擎社区。这种产学研结合的发展模式,为技术的持续创新奠定了坚实基础。

2 Flex:ai的主要功能和特点

2.1 算力资源精细切分

Flex:ai的核心功能之一是将单张GPU/NPU算力卡切分为多个虚拟算力单元,切分粒度可精准至10%。这意味着,一张A100 GPU可以划分为10个10%的虚拟单元,同时承载10个小模型训练或推理任务,彻底改变了过去”一张卡跑一个任务”的资源浪费模式。 这一技术由华为与上海交通大学联合研发,通过弹性灵活的资源隔离技术,确保多任务间互不干扰,实现”用多少,切多少”的按需分配。在实际应用中,这种细粒度切分可使算力资源平均利用率提升30%,而虚拟化性能损耗控制在5%以内。

2.2 跨节点算力资源聚合

针对集群中大量通用服务器缺乏智能计算单元的问题,华为与厦门大学联合研发了跨节点拉远虚拟化技术。该技术能够将集群内各节点的空闲XPU算力聚合形成”共享算力池”,为高算力需求的AI工作负载提供充足资源支撑。 厦门大学设计的上下文分离技术打破了XPU的服务范围限制,可以使集群外部碎片减少74%,提升67%高优作业吞吐量。这意味着,不具备智能计算能力的通用服务器可通过高速网络,将AI工作负载转发到远端”资源池”中的GPU/NPU算力卡中执行,从而实现通用算力与智能算力资源的深度融合。

2.3 多级智能调度系统

Flex:ai的智能调度器Hi Scheduler由华为与西安交通大学共同打造,能够自动感知集群负载与资源状态,结合AI工作负载的优先级、算力需求等多维参数,对本地及远端的虚拟化GPU、NPU资源进行全局最优调度。 这一调度系统采用三类核心策略实现算力精准匹配:

- 高优先级任务抢占:直接夺取资源保障关键任务完成

- 闲时分时调度:低优先级任务在夜间等闲时执行提升利用率

- 数据驱动触发:增量数据达到阈值自动启动训练流程

即使在负载频繁波动的场景下,Hi Scheduler也能保障AI工作负载的平稳运行,让每一份算力都”物尽其用”。

2.4 异构算力统一管理

Flex:ai支持多品牌、多规格的异构算力资源统一调度,包括英伟达GPU、华为昇腾NPU等不同芯片架构。这一特性使得企业无需重写代码即可平滑切换硬件,大幅降低迁移成本。 通过”物理层-虚拟层-应用层”的三层池化架构,Flex:ai打破不同厂商、规格算力卡的资源壁垒,深度整合昇腾NPU的同时保持对第三方芯片的中立支持。这种开放架构为企业提供了更大的硬件选择空间,避免被单一厂商锁定。

3 如何使用Flex:ai?

3.1 环境准备与部署

Flex:ai基于Kubernetes容器编排平台构建,这意味着用户需要准备Kubernetes集群环境作为技术底座。对于已有Kubernetes环境的企业,可以相对容易地集成Flex:ai组件。 部署过程主要包括以下步骤:

- 从魔擎社区下载Flex:ai源码或部署包

- 通过自定义资源定义(CRD)扩展Kubernetes对GPU/NPU的细粒度管理能力

- 配置Hi Scheduler智能调度器策略

- 设置监控和运维体系

Flex:ai支持本地数据中心、边缘环境和云端部署,提供灵活的全场景覆盖能力。

3.2 算力切分配置

用户可以通过API或UI界面提交虚拟算力单元申请,系统会根据需求自动进行资源切分。切分粒度可以从10%到100%灵活配置,满足不同规模的AI工作负载需求。 例如,对于小模型推理场景,可以设置为10%-20%的细粒度切分;而对于大型训练任务,则可以分配整卡或多卡资源。这种”用多少,切多少”的动态分配机制,确保了资源的高效利用。

3.3 任务调度与管理

Flex:ai提供多种调度策略供用户选择,包括Binpack(紧凑打包)、Spread(均匀分布)等10余种算法。用户可以根据任务特点选择合适的调度策略。 任务生命周期管理包括:

- 用户通过API/UI提交虚拟算力需求

- Hi Scheduler进行物理资源智能匹配

- 弹性隔离技术构建独立运行环境

- 任务执行过程中的实时监控

- 任务结束后资源自动释放

3.4 运维监控

Flex:ai提供完善的可视化运维监控体系,包括实时利用率曲线、异常告警阈值等功能。据测试,其故障定位时间较传统模式缩短50%,显著提升运维效率。 系统还提供多租户安全隔离能力,从基础设施层实现数据与算力资源的安全隔离,满足企业级安全需求。

4 Flex:ai的官方地址与获取方式

Flex:ai已于2025年11月21日正式开源至魔擎社区(华为与中科院软件所共同运营的开源社区)。开发者可以访问社区获取完整源码、文档和部署工具。 华为还将Flex:ai与之前开源的Nexent智能体框架、DataMate数据工程、AppEngine应用编排、UCM推理记忆数据管理器等工具共同集成,形成完整的ModelEngine开源生态,为用户提供从数据预处理到模型训练、推理的一站式AI解决方案。 魔擎社区目前活跃度较高,日均访问量超1.6万,版本下载量3万+次。社区提供详细的技术文档、部署指南和最佳实践案例,帮助用户快速上手。

5 Flex:ai vs 竞品对比分析

5.1 与技术竞品的功能对比

为了全面评估Flex:ai的市场竞争力,我们将其与主流AI算力虚拟化方案进行多维度对比: 表:Flex:ai与主要竞品技术参数对比

| 技术维度 | 华为 Flex:ai | 趋动 OrionX | 英伟达 Run:ai | 阿里云 cGPU |

|---|---|---|---|---|

| 切分粒度 | 10%(动态) | 任意粒度(动态) | 25%(静态) | M级显存(静态) |

| 虚拟化范围 | 本地+跨节点拉远 | 跨节点池化 | 单节点容器共享 | 单节点容器共享 |

| 性能损耗 | <5% | <2%(远程) | <3% | <1% |

| 异构算力支持 | 强(英伟达GPU、昇腾NPU等) | 强(多厂商AI芯片) | 弱(仅英伟达GPU) | 无(仅NVIDIA芯片) |

| 调度策略 | 多级智能调度 | 算力QoS技术 | 优先级与队列机制 | 固定策略框架 |

5.2 差异化优势分析

从对比可以看出,Flex:ai的三大差异化优势为:

- 跨架构调度能力:相比Run:ai主要服务于英伟达GPU生态,Flex:ai没有生态限制,支持英伟达GPU、华为昇腾NPU等多类型芯片的统一调度

- 开源生态优势:Flex:ai全面开源,而Run:ai等竞品多为商业闭源软件,开源策略降低了企业使用门槛,促进生态共建

- 动态切分灵活性:支持10%的细粒度动态切分,而Run:ai采用25%静态分片,Flex:ai能更好适应多样化工作负载

上海交通大学戚正伟教授指出:”Flex:ai的异构兼容性更优于Run:ai,其开放架构将推动国产算力生态标准化。”

6 Flex:ai的典型应用场景

6.1 教育科研场景

在教育领域,Flex:ai可帮助高校和科研机构提升有限算力资源的利用效率。例如,某高校AI实验室通过Flex:ai将GPU利用率从40%提升至70%,支持更多学生同时进行模型训练,显著降低了算力使用门槛。 对于AI教学和实验环境,Flex:ai的细粒度切分能力使得多个学生可以共享同一物理显卡,进行小规模模型训练和推理实验,避免了过去”一人占一卡”的资源浪费现象。

6.2 医疗行业应用

在医疗领域,Flex:ai为医疗影像分析、病理诊断等AI应用提供高效算力支撑。瑞金医院与华为联合打造的多模态病理大模型”RuiPath”,用于识别病理切片病灶区域,覆盖19个常见癌种。 该模型基于103万张病理切片数据训练而成,但仅用16张昇腾910B算力卡便可完成大规模训练。这背后离不开Flex:ai的技术支撑,其通过算力资源切分、智能任务调度等技术,将XPU资源可用度从40%提升至70%,破解了有限算力下的大规模训练难题。

6.3 金融风控场景

金融机构对实时风控和欺诈检测有高要求,需要高效完成大模型训练。某券商通过Flex:ai优化大模型训练流程,将反欺诈模型训练周期从7天压缩至18小时,大幅提升业务响应速度。 Flex:ai的智能调度能力还能根据业务优先级动态分配算力资源,确保高优先级的线上推理任务获得足够资源,而训练任务则可以在业务低峰期执行,实现资源分时复用。

6.4 多行业通用场景

除了上述特定场景外,Flex:ai还在互联网、智能制造、物流等80多个高算力需求行业有广泛应用前景。特别是在”东数西算”等国家工程背景下,高效算力调度技术成为优化算力布局的关键抓手。

7 Flex:ai能为用户带来的价值

7.1 成本效益提升

Flex:ai最直接的价值是显著降低算力成本。通过将算力利用率从行业平均的30%-40%提升至70%,相当于在不增加硬件投资的情况下实现算力翻倍。 对于中小企业而言,Flex:ai的开源特性大幅降低了使用门槛,企业无需购买大量高端算力硬件,通过”算力精细化管理”即可提升现有硬件利用率,实现降本增效。测算数据显示,采用Flex:ai技术后,企业硬件成本可降低30%以上。

7.2 技术门槛降低

Flex:ai通过统一API和管理界面,屏蔽底层硬件差异,使AI应用开发者无需关注底层硬件细节,可以更专注于算法和模型本身。 这种硬件无关性设计,使得企业可以更灵活地选择算力硬件,避免被单一厂商锁定,同时也为国产算力芯片的应用提供了良好基础。

7.3 产业生态影响

Flex:ai的开源策略有助于推动算力调度标准化,通过凝聚产学研共识,形成行业通用的异构算力虚拟化与调度标准,避免”生态竖井”。 华为公司副总裁、数据存储产品线总裁周跃峰表示:”AI容器软件一定要和更多模型生态和多样性算力生态进行适配、对接以及调优。我们希望通过开源共建让AI真正走向平民化。”这一理念体现了Flex:ai在推动AI技术普及方面的社会价值。

8 Flex:ai最新重大更新动态或新闻

8.1 2025年11月21日:Flex:ai正式发布并开源

2025年11月21日,华为在上海练秋湖研发基地举办2025 AI容器应用落地与发展论坛,正式发布AI容器技术Flex:ai,并宣布将其开源至魔擎社区。此举被视为华为在AI基础软件领域的重要布局,也是对英伟达Run:ai等解决方案的正面回应。 华为公司副总裁、数据存储产品线总裁周跃峰在媒体采访中多次强调”要让AI在千行百业落地”,而Flex:ai正是实现这一目标的关键技术支撑。

8.2 产学研联合开发模式

Flex:ai的研发采用了深度融合高校科研力量的模式,联合上海交通大学、西安交通大学与厦门大学共同开发。这种产学研结合的模式,既保证了技术的前沿性,也为技术产业化落地提供了良好基础。 其中,上海交通大学负责XPU池化框架研发,厦门大学攻克跨节点拉远虚拟化技术,西安交通大学则主导Hi Scheduler智能调度器设计,各高校发挥专长,形成技术合力。

8.3 行业应用试点推进

目前,Flex:ai已在教育、医疗和金融等行业试点应用,并取得显著效果。除前述的瑞金医院案例外,多个行业的代表性企业都已开始尝试使用Flex:ai优化其AI算力使用效率。 随着Flex:ai的开源,预计将有更多企业加入技术应用生态,形成规模化示范效应,进一步推动AI技术在千行百业的落地应用。

9 常见问题FAQ解答

9.1 Flex:ai与华为昇腾芯片的关系是什么?

Flex:ai支持多种异构算力,包括英伟达GPU和华为昇腾NPU。在昇腾芯片上,Flex:ai通过软硬件协同优化实现最佳性能功耗比,但它并不依赖特定芯片,而是保持硬件中立性。

9.2 Flex:ai的性能损耗如何?

Flex:ai的虚拟化性能损耗控制在5%以内,远低于其带来的利用率提升效益。在实际应用中,算力利用率可从30%-40%提升至70%,性能损耗相对于收益几乎可以忽略不计。

9.3 中小企业如何使用Flex:ai?

中小企业可以通过魔擎社区获取Flex:ai开源代码,根据官方文档进行部署和使用。对于技术能力有限的企业,也可以选择华为云或生态伙伴提供的已集成Flex:能力的云服务,降低使用门槛。

9.4 Flex:ai是否需要改变现有的AI应用代码?

不需要。Flex:ai设计目标之一就是屏蔽底层硬件差异,现有AI应用无需修改代码即可享受其带来的效率提升。企业可平滑迁移现有应用到Flex:ai平台,无需重写代码即可实现硬件资源优化。

9.5 Flex:ai支持哪些AI框架?

Flex:ai支持TensorFlow、PyTorch等主流AI框架。由于基于容器技术实现,应用只需打包为容器镜像即可在Flex:ai平台运行,具有高度的框架兼容性。

9.6 Flex:ai是否可以用于模型训练和推理?

是的,Flex:ai同时支持AI模型训练和推理场景。对于训练任务,可通过智能调度优化资源分配;对于推理任务,细粒度切分能力使其可以高效处理并发推理请求。

10 总结

华为Flex:ai作为AI算力管理领域的一次重要突破,通过”软件定义算力”的技术创新,有效解决了AI产业面临的算力资源浪费问题。其三大核心技术——算力资源精细切分、跨节点资源聚合和多级智能调度,共同构成了高效的算力资源管理体系。 Flex:ai的最大价值在于将行业平均算力利用率从30%-40%提升至70%,这意味着同量硬件投资可产生双倍算力供给,对于降低AI应用门槛、推动技术普及具有重要意义。其开源策略和异构兼容特性,进一步增强了技术的可及性和公平性。 随着AI技术向各行各业渗透,算力效率将逐渐取代单纯算力规模,成为产业竞争的关键要素。Flex:ai代表的”效率驱动”模式,为AI产业发展提供了新思路,也为中国在AI基础软件领域参与全球竞争奠定了坚实基础。

参考文章或数据来源

- 华为开源突破性技术Flex:ai,AI算力效率直升30%,GPU、NPU一起用(2025年11月22日)

- 华为开源AI容器软件Flex:ai将大幅提升算力资源利用率(2025年11月21日)

- 对标英伟达,华为开源AI容器技术Flex:ai 它可使算力平均利用率提升30%(2025年11月21日)

- 苹果Android首次实现跨平台互通/华为发布重磅AI技术/ChatGPT群聊功能正式上线(2025年11月22日)

- OCP峰会三大亮点:模块化、两相冷却与800V直流供电(2025年10月14日)

- 华为Flex:ai AI容器软件发布及核心信息解析(2025年11月22日)

- 一文读懂华为Flex:ai技术原理和架构设计(2025年11月21日)

- 华为Flex:ai重磅发布!算力革命引爆万亿赛道,6家核心公司锁定开源红利(2025年11月23日)

- GitHub – getflexai/flex_ai: simplifies fine-tuning and inference for 60+ open-source LLMs through a single API(最新更新2024年11月9日)

- “我被机器解雇了!”Amazon 63岁员工因算法评分太低被自动开除(2021年7月1日)

- 【产业资讯】华为Flex:ai发布!AI容器掀起算力革命,利用率飙升重构产业生态(2025年11月23日)

本文基于公开资料整理,内容更新至2025年11月24日,仅供参考学习。

数据统计

更多AI产品信息

华为Flex:ai

已有 1,128 次访问体验

已收录

申请修改

华为Flex:ai的官网地址是?

华为Flex:ai的官网及网页版入口是:https://www.huawei.com/cn/open-source/ 官网入口👈

网站流量数据说明

网站数据仅供参考。评估因素包括访问速度、搜索引擎收录、用户体验等。 如需获取详细数据(如IP、PV、跳出率等),请联系站长获取。

推荐数据源

爱站/AITDK

关于华为Flex:ai的特别声明

AI产品库AIProductHub是一个专注于AI产品收录与分享的网站平台,平台收录了1000余款AI产品,覆盖创作、办公、编程、视频生成、电商、设计、写作、图像生成等多个领域和行业,平台旨在帮助更多的用户发现更好用的AI产品。本站【AI产品库AIProductHub】提供的【华为Flex:ai】信息来源于网络。 对于该外部链接的指向,不由【AI产品库AIProductHub】实际控制。【华为Flex:ai】在【2025-11-24 01:10】收录时, 该网页内容属于合规合法,后期如出现违规内容,可直接联系网站管理员删除,【AI产品库AIProductHub】不承担任何责任。

本文地址:https://aiproducthub.cn/sites/huawei-flex-ai.html 转载请注明来源

相关导航

BigQuery AI是谷歌推出的智能数据分析平台,让用户通过自然语言指令即可完成复杂的数据分析与机器学习任务。

INK For All

本文是一份全面的 INK For All 使用指南,涵盖从产...

Tabnine AI Code Assistant

Tabnine is the AI code assistant that accelerates and simplifies software development while keeping your code private, secure, and compliant.

飞象老师

飞象老师是专为教师设计的AI工具,一句话即可生成交互教学动画与游戏课件,免费面向全国教师开放。

txyz

txyz.ai是集成论文搜索、阅读、问答和写作的AI学术平台,与arXiv官方合作,帮助研究者高效获取知识。

Seele AI

Seele AI是一款通过自然语言输入即可生成完整3D游戏和虚拟世界的AI创作平台,支持多模态交互和实时编辑。

Boba

Boba是一款AI动漫视频生成平台,能将静态图像转化为带唇形同步的动态动漫视频,适合短视频创作者快速制作内容。

咔片PPT

咔片PPT是一款AI驱动的在线PPT制作工具,通过智能内容生成和模块化设计,大幅提升演示文稿制作效率。

暂无评论...